NVIDIA在GTC 2025不僅公布Blackwell Ultra加速運算GPU,還宣布對於當前資料加速運算產業相當重要的開源AI推論服務軟體NVIDIA Dynamo;NVIDIA Dynamo是作為協調與加速數千個的GPU的推論通訊,利用分散式運算特性於大型語言模型的處理與產生分配到不同的GPU,可針對特定需求單獨將每個階段最佳化;NVIDIA Dynamo不僅完全開源,還支援包括PyTorch、SGLang、NVIDIA TensorRT-LLM和 vLLM,企業、新創與研究人員可使用熱門的AI框架進行部署,同時實現分散式推論,可提升AI工廠(AI Factory)服務的性能、縮減回應時間與降低模型服務成本。

NVIDIA Dynamo即日起以完全開源形式於GitHub開放開發者存取使用,同時也將在NVIDIA NIM微服務提供,計畫後續獲得NVIDIA AI Enterprise軟體平台資源提供企業更高層級的安全性、支援與穩定性。

▲NVIDIA Dynamo能使具備大量GPU的AI工廠更有效率的以分散式運算方式提升性能,並針對GPU、記憶體等資源進行協調

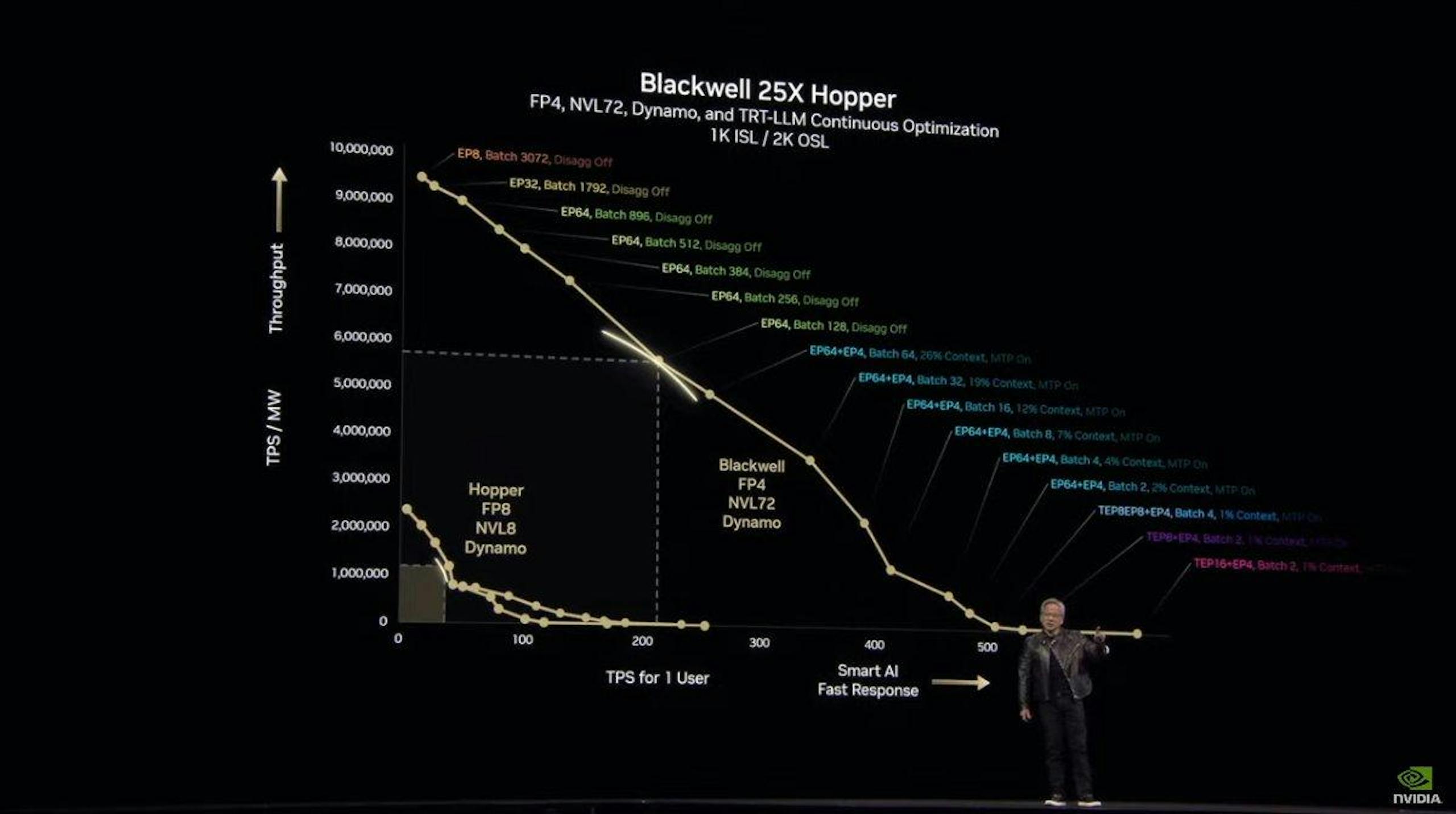

NVIDIA Dynamo定位在NVIDIA Triton Inference Server的後繼者,旨在為AI工廠提供高效的測試階段擴展運算解決方案,能為以執行推論AI的AI工廠提供最大化的詞元收益,透過針對分散式運算架構進行海量GPU的加速與協調,透過整合多項功能提高傳輸量與降低成本,具備動態新增、移除與重新分配多個GPU資源的能力,可有效率的將大型語言模型的處理與生成階段分配到不同GPU執行,並可針對特定需求將每個階段更有效的最佳化,可在AI工廠的大型叢集精確定位特定GPU減少回應運算與路由查詢,還具備將推論資料卸載至成本更低的記憶體與儲存裝置,並於需要時快速取得,使AI工廠的大量GPU能最大化資源使用率。

NVIDIA Dynamo將推論系統從先前請求中儲存在記憶體的「知識」(KV快取)映射到叢集的數千個GPU,接著將新的推論請求轉移到知識相符最高的GPU,可避免消耗資源重新運算,同時釋放GPU回應新的輸入需求。NVIDIA Dynamo包含四大創新技術,包括可動態增加或移除GPU的GPU規劃器,可感知大型語言模型並在大型GPU叢集引導請求的智慧路由器,還有經過推論最佳化的低延遲通訊函式庫,與不影響使用者體驗智慧進行資料卸載貨重新載入至更低成本的記憶體與儲存的記憶體管理器。

NVIDIA執行長黃仁勳表示NVDIA Dynamo不僅能使新一代的Blackwell架構的AI工廠受益,基於大量Hopper GPU的AI工廠也同樣能夠受益,然而由於架構的世代落差,Blackwell能夠獲得更顯著的效能提升。