NVIDIA為了促使開放、高效且具擴充的資料中心,持續向開放運算計畫(OCP)貢獻高效能運算硬體架構,其中也包括引領目前AI與高效能運算的NVDIIA HGX H100;隨著Blackwell架構供部,NVIDIA於2024年10月舉辦的OCP高峰會重磅宣布將Blackwell加速運算平台設計的基礎要素貢獻給OCP,同時擴大NVIDIA Spectrum-X支援OCP標準的程度。

NVIDIA將透過OCP社群分享NVIDIA GB200 NVL系統機電設計的關鍵組成,包括機架架構、運算與交換器托盤機構、液冷與熱環境規格,還有由NVIDIA NVLink纜線構成的體機容量、藉此支援更高運算密度與網路頻寬。同時NVIDIA也促使NVIDIA Spectrum-X乙太網路平台更符合OCP社群制定的規格,使企業部署OCP認證設備,在保有既有投資與軟體一致性發揮AI工廠的潛力。

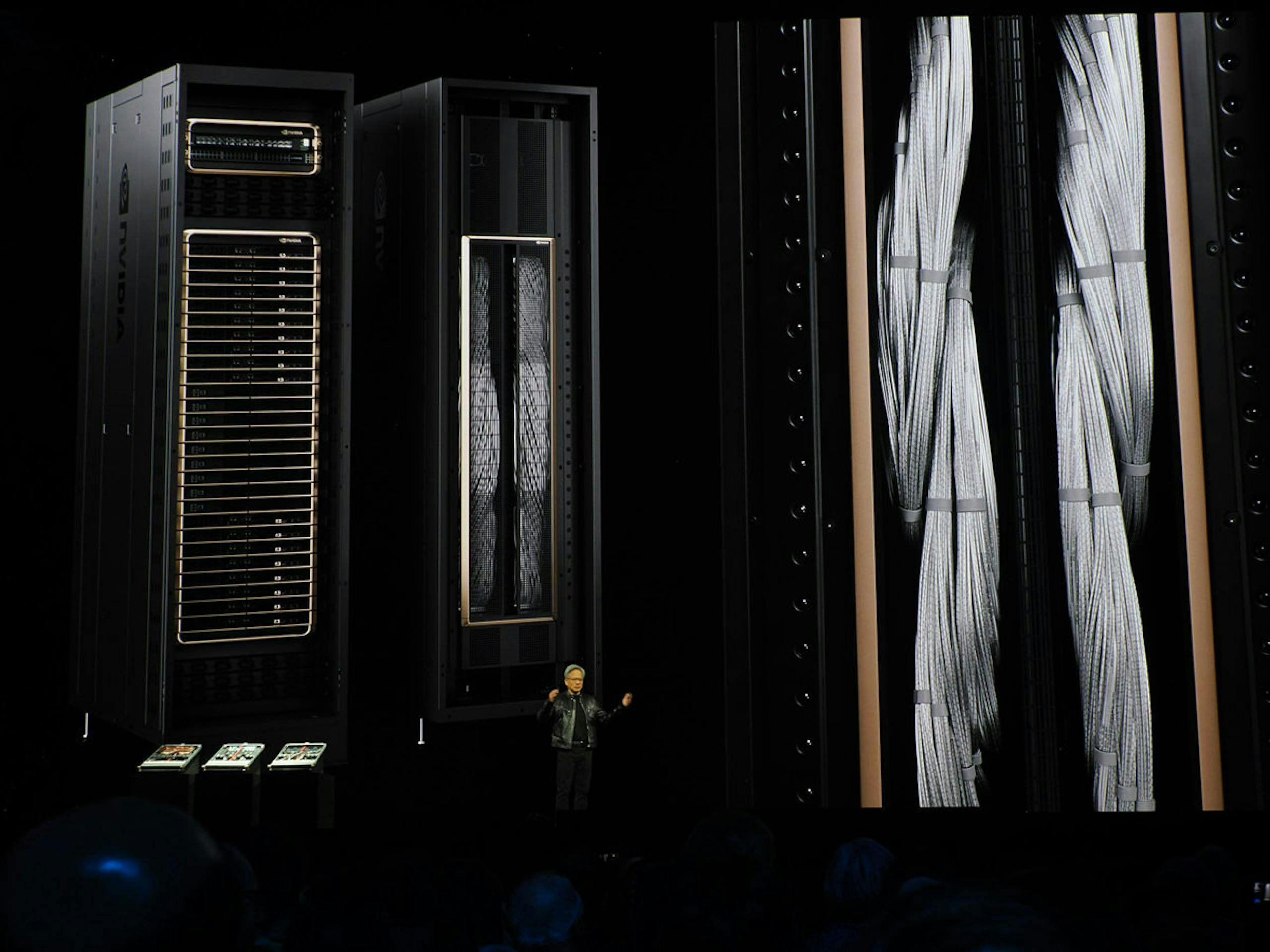

▲NVIDIA持續向OCP貢獻加速平台設計,推動開放、高效且具擴充力的資料中心技術

NVIDIA GB200 NVL72為基於NVIDIA MGX模組化架構的設計,旨在使製造商以符合成本效益的方式建構大量資料中心基礎設施;GB200 NVL72串接36個NVIDIA Grace CPU與72個NVIDIA Blackwell GPU,同時採用液冷冷卻,而72個Blackwell GPU透過NVIDIA NVLink網域高速連接、視同單一大型GPU,在執行上兆參數的大型語言模型執行推論的性能相較NVIDIA H100 Tensor Core GPU快30倍。

藉由加入NVIDIA ConnectX-8 SuperNIC的NVIDIA Spectrum-X乙太網路,能支援OCP的交換機抽象層介面(Switch Abstraction Interface/SAI)與Software for Open Networking in the Cloud(SONiC)標準。用戶即可透過Spectrum-X的動態路由和基於遙測的壅塞控制技術加速橫向擴充式 AI 基礎設施的乙太網路效能。ConnectX-8 SuperNIC提供達800Gb/s的加速網路與針對大規模AI工作負載最佳化的可程式化資料包處理引擎。適用於OCP 3.0的ConnectX-8 SuperNIC預計於2025年推出,將協助企業建構高度靈活的網路。

隨著產業自通用運算轉型為加速運算與AI運算,資料中心基礎設施也日益複雜;NVIDIA與全球40家產業相關產品製造商攜手,為AI工廠提供關鍵元件,希冀簡化開發流程。同時多家合作夥伴也積極建構基於Blackwell的平台與進行創新,其中Meta正計畫將其採用GB200 NVL72的Catalina AI機架貢獻給OCP,使系統業者能做為參考。