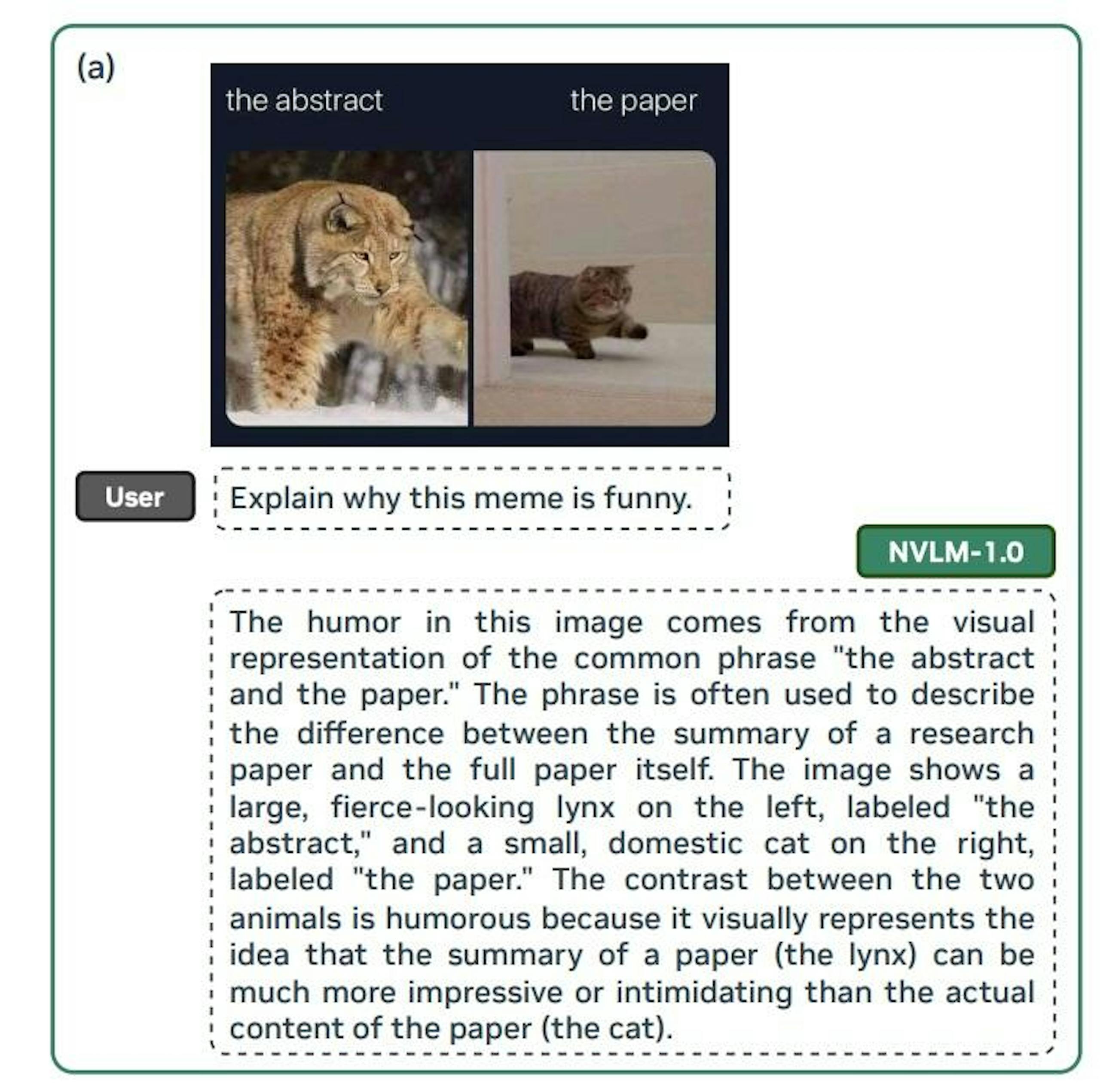

NVIDIA研究團隊重磅釋出NVLM 1.0開源多模態大型語言模型,最大版本NVLM-D-72B達720億參數(72B),開發團隊聲稱其視覺語言精確度媲美業界領先的GPT-4o私有模型以及Llama 3-V 40.5B、InternVL 2等開源模型,在舉出的例子甚至還包括理解迷因圖;不過NVLM 1.0旨在強化AI產業的發展,僅供作為研究,不允許商業使用。

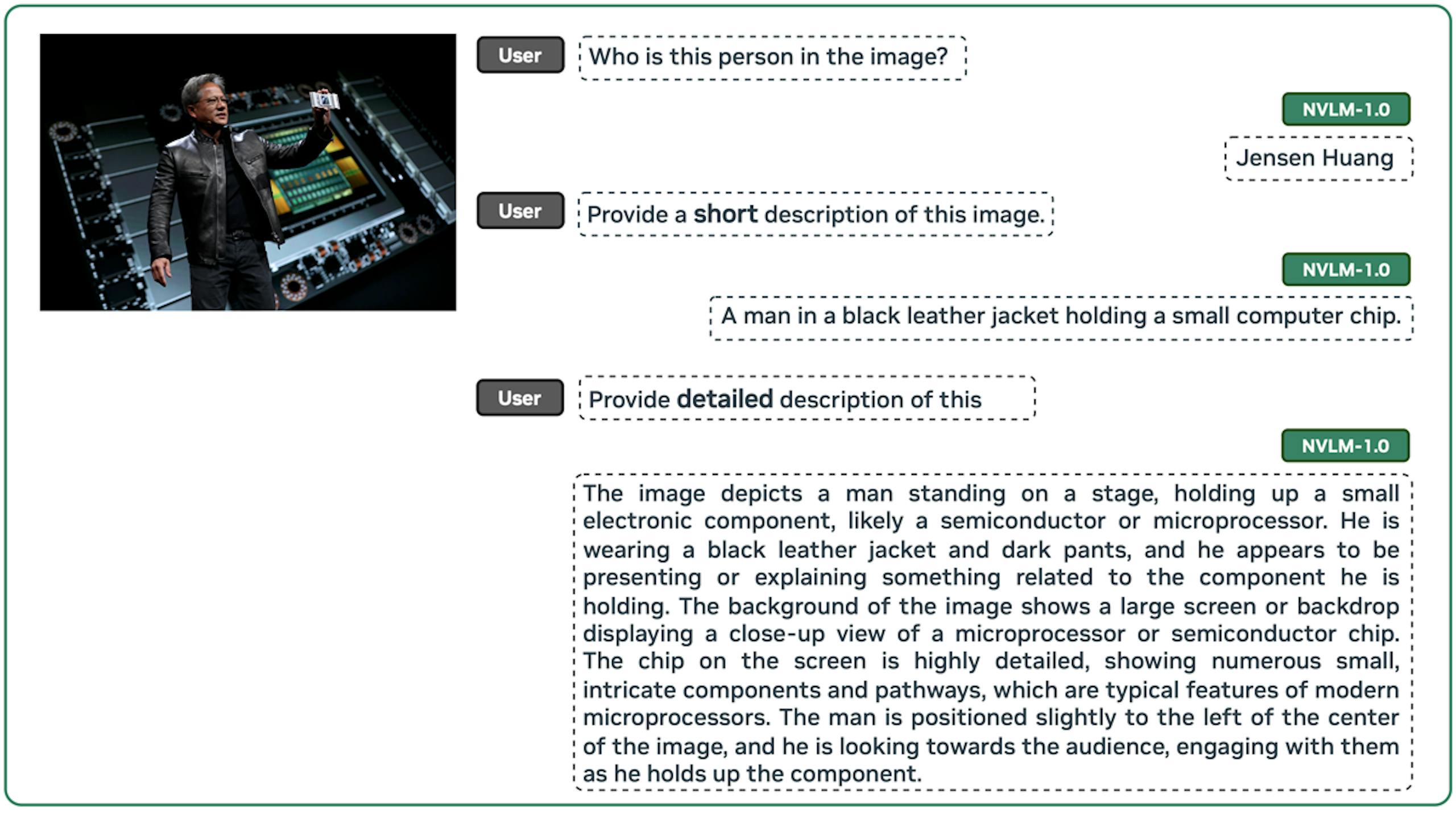

▲以執行長黃仁勳的照片為例展現出色的指令追蹤能力,並為圖片提供高品質且詳盡的描述

▲甚至可以理解迷因圖背後想表達的意涵

NVIDIA研究團隊表示NVLM 1.0可在視覺語言與純文字的項目與領先的大型語言模型相當,甚至在OCRBench 和 VQAv2領先所有的模型,也強調在所有測試項均勝過或至少與私有的GPT-4o打平,同時NVLM-1.0 72B在多模態測試的表現也優於Google的Gemini 1.5 Pro。