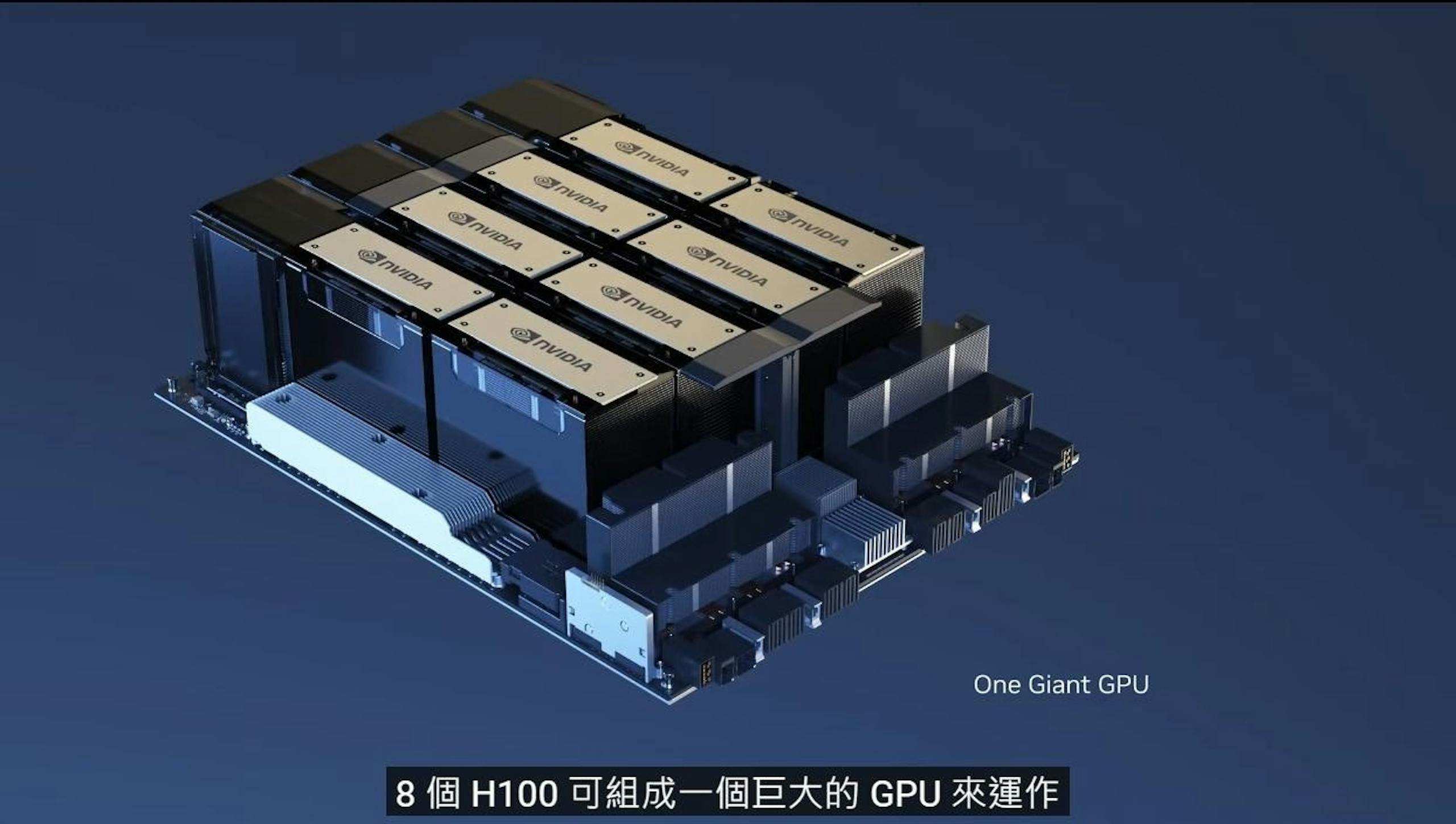

Tesla創辦人、同時也是社群服務X董事長Elon Musk宣布xAI建構的超大型GPU叢集已投入GROK 3的模型訓練,xAI的超大型叢集由高達10萬個使用液冷的NVIDIA H100 GPU構成,是目前全球最大規模的RDMA單一GPU叢集。在xAI的叢集投入服務後,xAI預計於2024年12月推出以該套系統建構的GROK 3模型,Elon Musk指稱屆時將會是全球最先進的AI模型。

Nice work by @xAI team, @X team, @Nvidia & supporting companies getting Memphis Supercluster training started at ~4:20am local time.

— Elon Musk (@elonmusk) July 22, 2024

With 100k liquid-cooled H100s on a single RDMA fabric, it’s the most powerful AI training cluster in the world!

▲可能由於xAI需要的GPU數量相當龐大、加上成本考量因素,故選擇H100而非記憶體增量的H200

原本xAI是向Oricle租賃雲服務進行GROK的模型訓練,不過xAI最後打算自行持有超級電腦;然而比較意外的是Elon Musk選擇的GPU以目前NVIDIA的產品藍圖有些尷尬,因為NVIDIA正陸續出貨具有更高容量且更高頻寬的NVIDIA H200,同時NVIDIA很快就會在2024年底至2025年初開始提供新一代Blackwell架構的B200 GPU,主要的原因恐怕與Elon Musk所需的GPU數量相當驚人,若要一次到位NVIDIA可能也難以在第一時間供應如此大量的新產品,同時Elon Musk對於價格也相當精打細算,故選擇已經問是一段時間的H100。