NVIDIA與Google Cloud於Cloud Next '24大會宣布共同展開新合作,旨在扶持全球新創加速建立生成式AI應用程式與服務,雙方將結合彼此的NVIDIA Inception、Google for Startup Cloud的新創公司扶持計畫,以擴大雲端積分(Cloud Credit)市場推廣支援與技術專業知識,協助新創公司更快為客戶提供價值。同時Google Cloud也宣布將在2025年初導入Google Blackwell架構產品並提供服務。

雙方計畫相互結合嘉惠生成式AI新創、加速產業發展

NVIDIA Inception是一項支持超過18,000家新創公司的全球計畫,合格會員能夠加速使用Google Cloud基礎設施,並獲得Google Cloud積分,而專注AI的企業可獲得最高350,000美金金夫、並可用於NVIDIA DGX Cloud加速服務。

在雙方展開的合作,Google for Startup Cloud計畫成員可加入NVIDIA Inception計畫,並獲得來自NVIDIA的專業技術知識支援、NVIDIA深度學習機構課程學分、NVIDIA硬體與軟體,計畫合格成員還可參與NVIDIA Inception Captial Connect,使新創公司能接觸對該領域感興趣的創投公司。同步參與兩項計畫的高成長新興軟體開發商可獲得加快入駐Google Cloud Marketplace、共同行銷與產品加速支援。

Google與NVIDIA雙方技術緊密結合

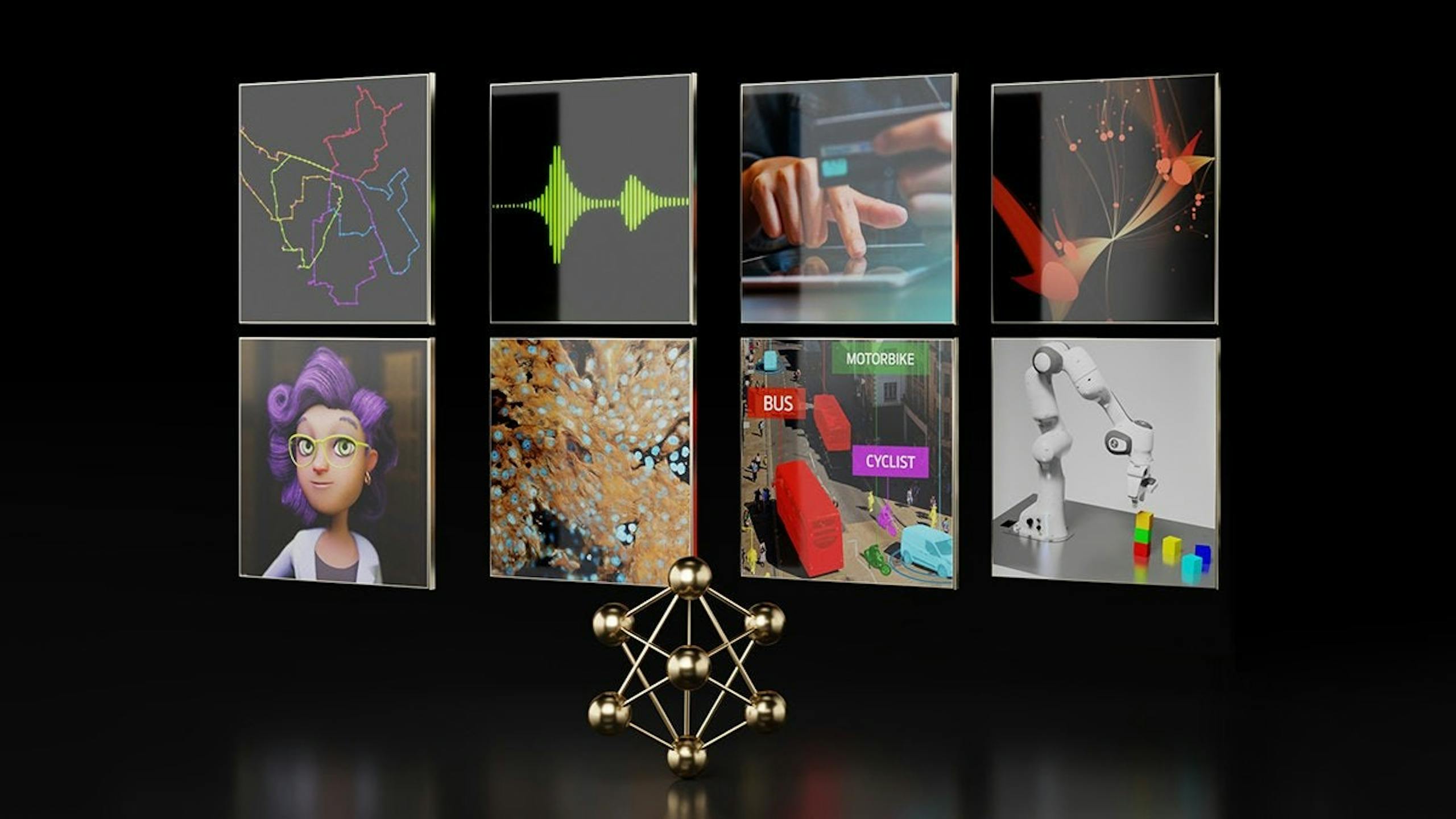

▲NVIDIA NIM微服務與Google Kubernetes Engine(GKE)一起為開發AI驅動應用程式與將最佳化AI模型部署到生產環境提供簡化路徑

NVIDIA與Google在近期針對Gemma開放模型於所有NVIDIA AI平台進行最佳化,能藉此降低客戶成本與加快特定領域創新;同時利用Google TensorRT-LLM最佳化大型語言模型推論開源庫加速Gemma於NVIDIA GPU執行的效能。

此外,作為NVIDIA AI Enterprise一環、甫於GTC 2024公布的NVIDIA NIM微服務,更是與Google Kubernetes Engine(GKE)一起為開發AI驅動應用程式與將最佳化AI模型部署到生產環境提供簡化路徑;NIM基於NVIDIA Triton推論伺服器、TensorRT-LLM等推論引擎,可支援各種領先的AI模型,提供無縫、可擴展的AI推論,幫助企業加速生成式AI部署。

包括Gemma 7B、RecurrentGemma、Cloud Gemma等Gemma系列模型可自NVIDIA API目錄取得,使用者可透過瀏覽器試用、使用API端點進行原型開發、並利用NIM進行自主託管。透過GKE與Google Cloud HPC工具套劍,Google Cloud使用戶可在平台部署NVIDIA NeMo框架,使開發者能自動化與擴展生成式AI模型的訓練與服務,並進行客製化藍圖快速部署完整環境。同時開發者也可自Google Cloud Marketplace取得NVIDIA NeMo。

Google A3 Mega由NVIDIA H100驅動、2025年Google Cloud導入Blackwell架構

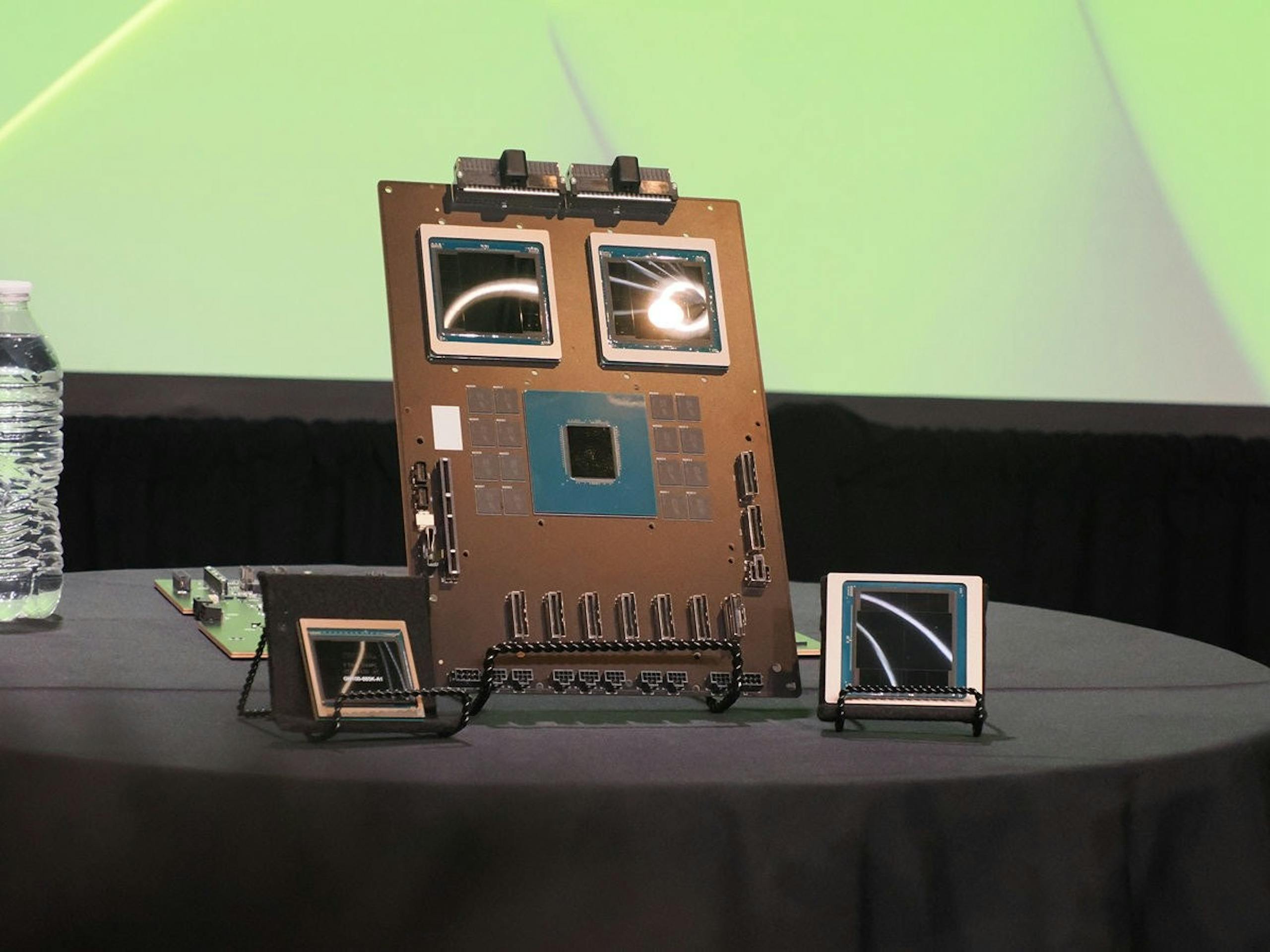

▲Google Cloud將在2025年初導入NVIDIA Blackwell架構

Google Cloud宣布2024年5月將全面提供A3 Mega執行個體,作為A3虛擬機器的擴展,並於NVDIIA H100 Tensor GPU驅動,A3 Mega將A3虛擬機器的GPU至GPU網路頻寬增加一倍;另外Google Cloud A3虛擬機器還預計在2024年提供預覽版的機密運算支援,幫助客戶保護敏感資料的機密性與完整性,並確保訓練與推論過程保護應用程式的AI工作負載,以及使用H100 GPU加速時不須更動程式碼。

此外Google Cloud也宣布將在2025年初導入NVIDIA Blackwell平台,包括搭配x86處理器的NVIDIA HGX B200,以及採用Arm CPU的NVDIIA GB200 NVL72多節點機架規模系統;其中HGX B200將鎖定AI、資料分析與高效能運算工作負載,而GB200 NVL72則為下一代前沿、大規模、兆級參數的模型訓練與推論提供充裕的記憶體與性能。