在2024年,NVIDIA首次在COVID-19疫情解封後將年度活動NVIDIA GTC大會恢復實體活動,吸引達1.5萬人報名前往美國加州聖荷西參與,也是歷屆規模與參與人數最大的一場GTC活動;筆者很幸運的在約十年前就陸續有機會參與GTC大會,然而自筆者開始接觸GTC活動之初,GTC大會的聲勢與規模與現在截然不同。

回到2012年的時空情境,台灣財經產業一片唱衰NVIDIA並表示隨時可能倒閉,但若從每年GTC的進展,不難看到當前NVIDIA在加速運算與AI的霸業早已有跡可循;以筆者個人的認知,NVIDIA當前的成功,建立在堅持發展認為有未來性的技術,並以GPU為核心一路擴展技術宇宙,待到對的時機、對的技術者與應用開花結果。

GTC 2012:仍處於萌芽的CUDA加速運算

▲2012年CUDA運算仍處在萌芽期,當年最大亮點是宣布GPU具備虛擬化能力

將時間回到2012年GTC大會,當時的GTC大會是在5月舉辦,由於當時GTC大會著重在圖形影像技術與還在萌芽期的GPU加速運算,活動時間又鄰近當時Intel聲勢仍相當浩大的COMPUTEX,同時NVIDIA又籠罩在Fermi架構筆電GPU,台灣媒體前往參加的意願不高;當年NVIDIA在GTC大會公布了後來大受好評的Kepler架構的加速卡產品、GPU虛擬化與雲端技術以及將Tegra平台轉戰車用智慧座艙。

當中的GPU虛擬化與雲端技術如今轉化為Omniverse協作平台的基礎以及雲端串流遊戲技術,並使遠端桌面也能享受高階GPU帶來的性能與算力,而Tegra的車載計畫則為後續NVDIIA宣布棄守手機與平板後將原本發展的技術轉到更具潛力的車用領域。值得注意的是2012年也是首次有科學家利用CUDA加速運算與深度學習打破AlexNet圖像辨識紀錄,首次使GPU加速與深度學習受到關注,也掀起後續CUDA崛起的浪潮。

補充個小插曲,當年愛車的NVIDIA執行長黃仁勳還自行開著法拉利前往會場,並將義大利紅的法拉利停放在會場旁San Jose的Marriot飯店門口,後續被幕僚「建議」這樣有點太招搖後,黃仁勳就不曾在自行開車參與GTC了,不過也顯露黃仁勳熱愛跑車的個性。

NVIDIA GTC 聚焦平行運算、雲端與虛擬化,帶來全新辦公與遊戲體驗

GTC 2013:Arm CPU與NVIDIA GPU首次擦出火花

▲GeForce Titan是NVIDIA首款跨娛樂與運算級產品,不過如今產品界線已越來越模糊

2013年的GTC大會,NVIDIA在同一年的CES宣布Tegra 4平台與NVIDIA Shield掌機,2013年的重點是聚焦在第一款跨界產品GeForce Titan上,在Titan問世前,消費級的GeForce與繪圖卡Quadro、加速卡Tesla壁壘分明,Titan則是以消費級金字塔頂端的價格但開放部分專業卡功能,可說是當年從事加速運算開發的平民神兵,產品定位類似於現行GeForce RTX 3090、GeForce RTX 4090。

2013年還展示透過Titan進行具備光線、臉部動作的即時3D人物頭部渲染。當時距離NVIDIA發表CUDA加速運算約5年,在GTC大會也宣布CUDA逐漸被超過50套超級電腦採用,並運用於氣象模擬、石油探勘等領域,同時也陸續被應用在數據分析、聲音辨識與圖像辨識;另一個2013年GTC的焦點則是NVIDIA展示結合Tegra 3與NVIDIA GPU的組合,也可視為現在NVIDIA提供給車載的高階版DRIVE與Grace Hopper Superchip、Grace Blackwell Superchip的雛型。

GTC 2013 : 不光只是科學研究,圖形運算更豐富我們的日常生活

GTC 2014:打破GPU運算限制的NVLink登場

▲Pascal首度導入NVLink,自此GPU運算的可能性大幅提升

距離現今10年前的GTC 2014可說是格外的重要,NVIDIA在大會公布Pascal架構的同時,也一併宣布奠定NVIDIA後續能夠擴大GPU運算潛力的NVLink技術;在傳統運算的觀念,CPU不僅是具備通用運算的能力,也是系統發號司令的中樞,所有的運算行為、資源調配都掌控在CPU手中,同時即便可安裝多張GPU,彼此之間的VRAM也無法併用,更不用說使GPU存取系統的DRAM;然而NVLink透過高速的雙向匯流排,使CPU與GPU具備對等溝通能力(前提是CPU需支援NVLink),也使多張GPU與其記憶體能夠合併、宛若一顆大型GPU一樣。

GTC 2014 :採 3D 製程架構與晶片對晶片溝通技術, NV 宣布次代 GPU 架構 Pascal

GTC 2015:POWER架構成首個支援NVLink的CPU,深度學習在影像辨識應用起飛

▲Power架構是首個支援NVLink的CPU,不過並未造成轟動

2015年的GTC大會聚焦在深度學習與自動駕駛技術,不過當時還有一項應該稱得上重要的插曲,就是基於IBM Power架構的OpenPower聯盟在GTC大會舉辦活動,OpenPower是當時唯一一個宣布支援NVLink的CPU架構,雖然最終有著性能出色的美國超級電腦作為實例,但畢竟Power架構當時已缺乏與x86競爭的能力,最終並未造成轟動,不過可視為現今GH200、GB200兩款SuperChip的老前輩。

在2015年GTC的另一個重要進展,則是當時人工智慧技術進入深度學習領域,也是GPU引領AI世代的重要開頭;相較傳統AI,深度學習藉由模仿人類的認知而具備自主學習能力;在2012年科學家首度利用CUDA平行運算結合深度學習,使AlexNet的圖像辨識達到8成,但在2015年,包括百度、微軟與Google等利用CUDA與深度學習,將錯誤率控制在5%內,使基於CUDA GPU的深度學習成為圖像辨識的顯學。

GTC 2015 :以開放伺服器架構引領創新的力量, OpenPower 聯盟於 GTC 舉辦活動

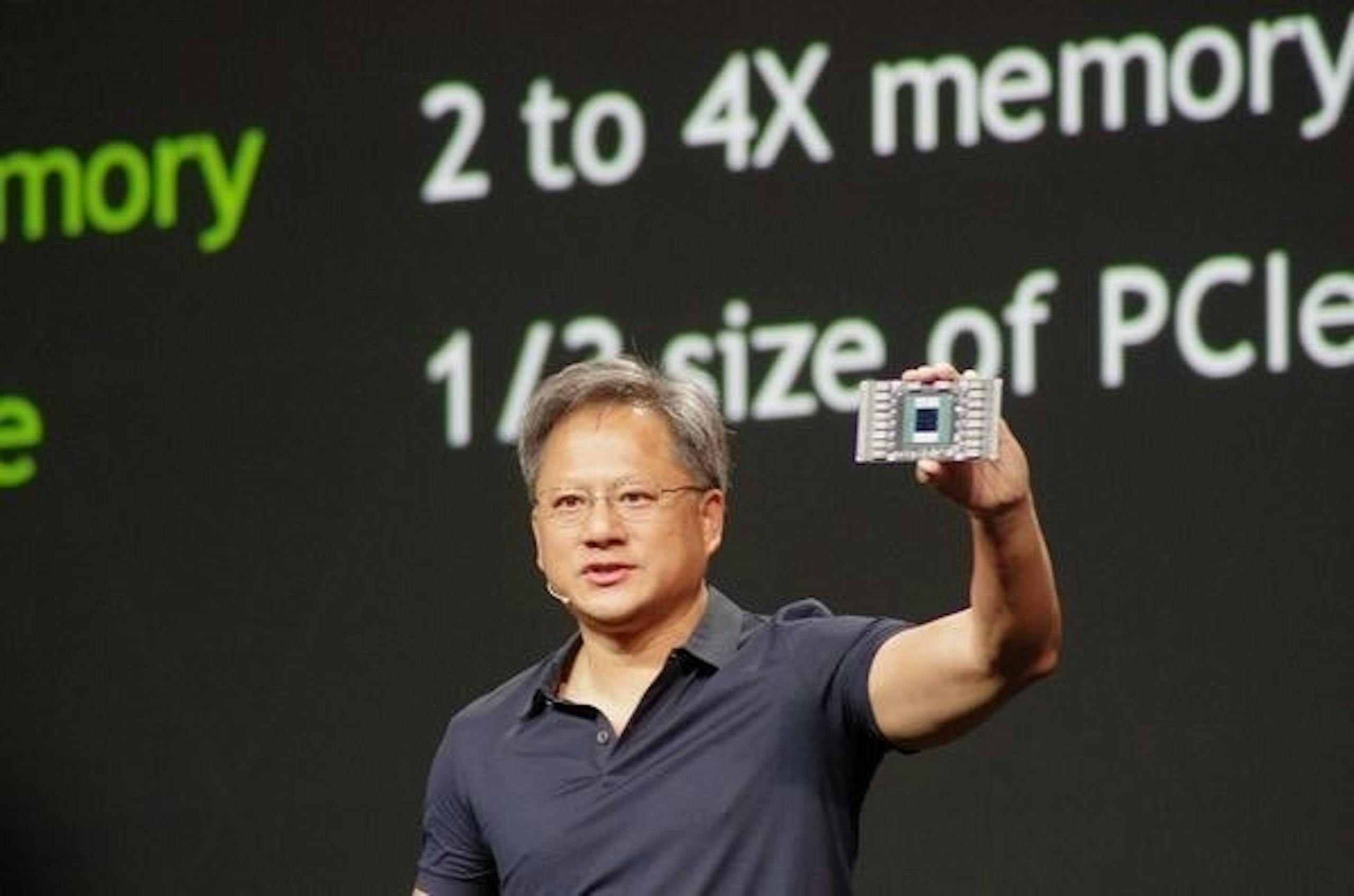

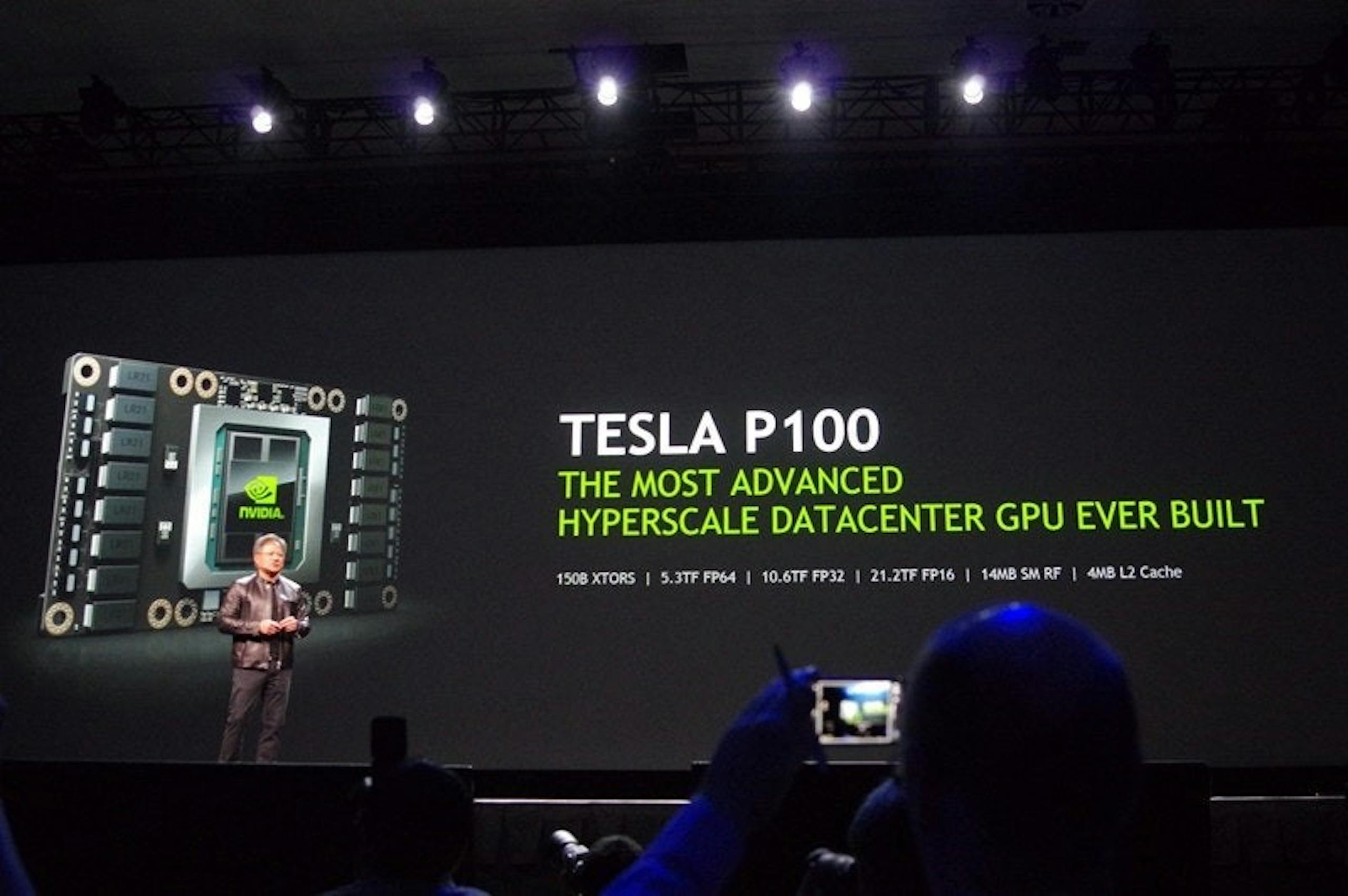

GTC 2016:Tesla P100與DGX系統正式亮相

▲Tesla P100與DGX-1使NVIDIA在資料中心進一步展露頭角

在預告兩年之久,NVIDIA於GTC大會正式公布結合Pascal架構與NVLink的Tesla P100,P100是NVIDIA首度利用NVLink使多個GPU能相互串接並共享記憶體,同時也採用HBM2記憶體提供更高的頻寬,這幾項特性也同時作為後續NVIDIA最高規加速器的架構元素;另一項重要的宣布是NVIDIA正式跨足伺服器領域,公布DGX-1系統。

DGX-1系統採用兩顆x86處理器與8張透過NVLink結合的Tesla P100,NVLink GPU子板再透過PCIe通道與CPU連接,借助NVLink串接多個GPU,DGX-1具備比傳統單一GPU更多的運算力與記憶體,同時NVLink使GPU記憶體共享,提升可運算的資料量,號稱單一系統的運算性能等同250台純x86 CPU系統的算力。

GTC 2016 : 導入 NVLink 與 HBM2 , NVIDIA 發表採 Pascal 架構專業加速器 Tesla P100

GTC 2017:整合Tensor Core的Volta與Tesla V100登場

▲Volta開啟NVIDIA將頂級HPC與AI加速架構與消費級架構獨立的先河,並導入深度學習加速器Tensor Core

基於Pascal架構的Tesla P100突破GPU運算與記憶體的上限,使GPU加速運算能夠滿足更多傳統超級運算的需要,然而2017年GTC大會所公布的Volta架構,則進一步使NVIDIA與AI密不可分,因為Volta架構不僅純性能提升與繼承P100支援NVLink、HBM記憶體等特色,也是第一款在架構整合針對AI深度學習加速的Tensor Core的產物。

過往的AI運算是仰賴CPU與GPU執行,原本CPU就擅長通用運算,而GPU加速運算則是使GPU能發揮類似CPU的通用運算功能,且以相較CPU更多的核心數量發揮超越CPU的表現;不過藉由針對AI深度學習加速的Tensor Core,能為深度學習的運算提供最佳化的運算加速效果,再結合Volta的CUDA Core的通用運算性能,使AI運算與傳統運算能兼顧並發揮最大效益;NVIDIA也自Volta架構之後將Tensor Core作為GPU必備的架構。

值得注意的是,Volta架構也是NVIDIA首次為AI HPC等加速運算規畫獨立的GPU架構,在此之前都是依循單一架構設計提供消費級、繪圖級與加速級產品,Volta架構則僅作為高階運算級產品專屬,同期的消費級架構由後續整合Tensor Core、RT Core的Turing(GeForce RTX)架構負責。

GTC 2017 : NVIDIA 主題演講引領 AI 革命,基於 Volta 架構的 Tesla V100 登場、 Xavier 將具備深度學習加速器

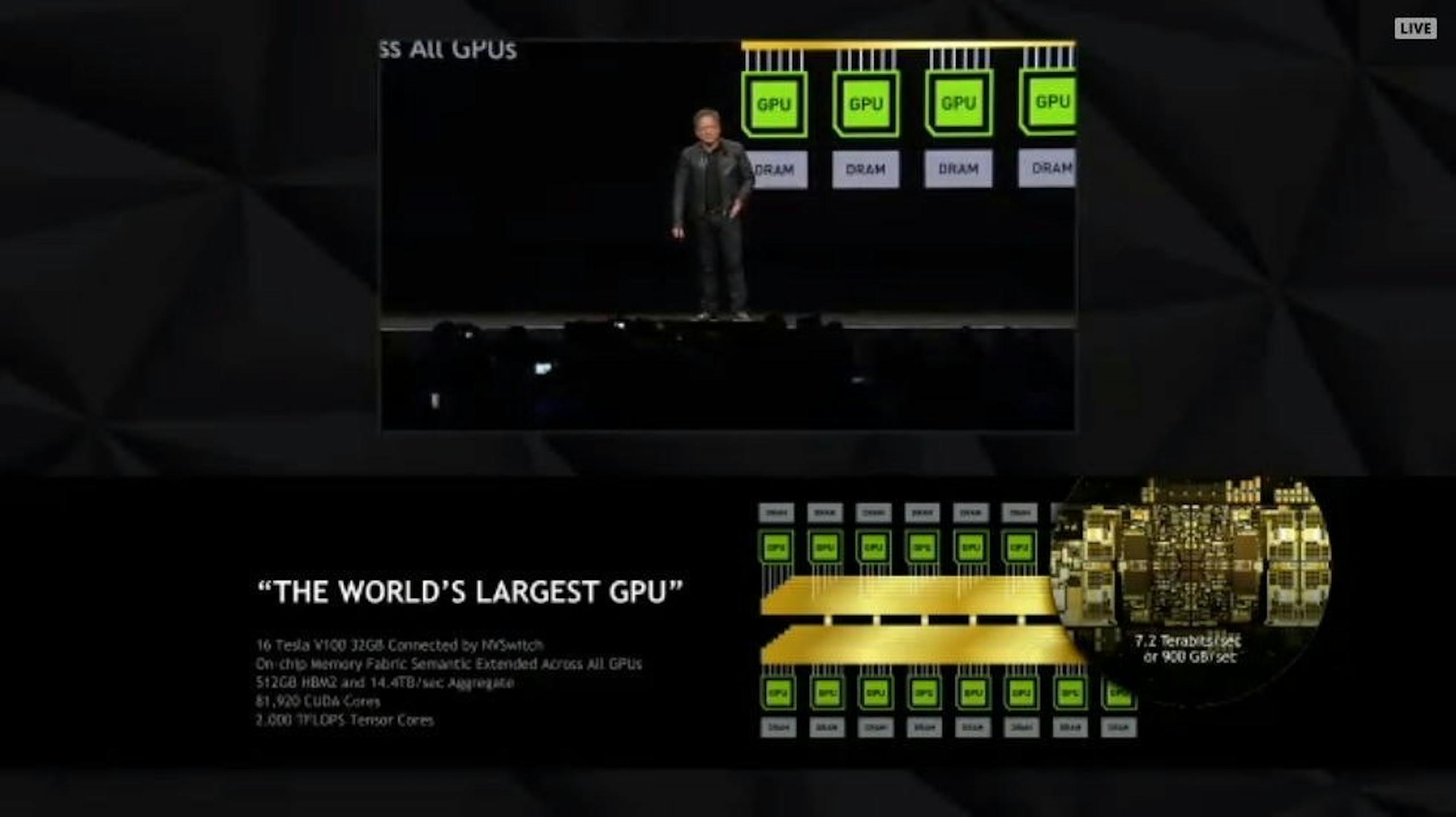

GTC 2018:DGX-2藉NVSwitch進一步擴大GPU互連規模

▲DGX-2導入NVSwitch使最多16個GPU能透過NVLink互連

採用第一代NVLink技術連接多GPU的DGX-1最多僅能連接8張GPU,然而NVIDIA在宣布Volta架構的隔一年公布DGX-2與NVLink Switch,借助NVSwitch交換器,將互連規模擴大到16張GPU,進一步擴大GPU運算的可能性,同時NVSwitch也在後續NVIDIA的加速運算扮演更吃重的角色。

GTC 2018 :搭載地表最大規模 GPU , NVIDIA DGX 2 藉 NVSwitch 技術串接 16 張 Tesla V100

GTC 2020:支援多重執行個體的Ampere架構

▲Ampere架構具備多重執行個體,同時也支援TF32精度

跳過相對在加速運算沒有太多著墨的2019年,2020年GTC雖仍壟罩在Covid-19陰影下改為全線上模式,不過NVIDIA在2020年公布第二款為AI加速運算而生的Ampere架構與NVIDIA A100,進一步擴大AI運算性能,同時還支援多重執行個體能力。

Ampere在架構設計具備多項特色,其Tensor Core支援TF32精度,使AI效能對比V100能夠提升20倍,同時也支援HPC所需的FP64精度。此外還導入結構化稀疏技術,以掌握AI數學的稀疏特性強化AI運算性能,同時還具備MIG多重執行個體GPU特性,使GPU可切割為7個執行個體進行獨立分工,同時亦可彈性分配資源進行協作,同時一套8顆A100 GPU可提供高達56個執行個體。

同時,NVIDIA也自2019年宣布Mellanox後繼承Mellanox的Infiniband等產品線,並在GTC 2020宣布BlueField-2 DPU,視為NIC的進階版產品,提供將部分工作的運算卸載功能,減少運算系統的CPU負擔,使CPU能更專注於運算內容;此時的NVIDIA也更進一步掌握系統當中的GPU、高速匯流排與互連網路功能,已不再是只有單一GPU技術的公司。

GTC 2020 : NVIDIA 發表地表最大 7nm 晶片、 Ampere 架構的 NVIDIA A100 GPU ,AI 性能提升 20 倍、具創新多重執行個體設計

GTC 2022:NVIDIA Grace CPU、Hopper攜NVLink-C2C亮相

▲Hopper架構支援FP8格式,同時還導入Transformer Engine與第二代MIG技術

NVIDIA在2021年的GTC同樣也沒有太多新硬體技術的著墨,但是2022年的GTC大會則格外的重要,因為除了兩年一度的加速運算GPU架構更新以外,NVIDIA更亮出挑戰AMD、Intel的CPU霸業的重要產品:Grace CPU,此外也一併宣布提供晶片對晶片高速連接的NVLink-C2C技術。不過2022年GTC活動公布的Grace內容較像是預告,介紹Hopper架構與NVIDIA H100才是重點。

Hopper是NVIDIA第三款針對AI加速運算的高階架構,延續CUDA、Tensor Core、HBM記憶體、NVLink等特性,Tensor Core還支援FP8格式,進一步使推論更具效益,同時第4代NVLink更使晶片外部連接的傳輸速度達到近5TB。

同時NVIDIA H100還導入針對自然語言處理的Transformer Engine技術,強調可在不耗損準確度的前提較A100提升6倍的深度學習速度;H100具備的第二代MIG技術不僅提供7個雲端租戶託管,還能進行跨雲端租戶的資源配置。

至於NVLink-C2C則是進一步實現NVIDIA加速運算願景的關鍵,畢竟受限x86陣營沒有意願配合NVIDIA支援NVLink,原本的CPU合作夥伴POWER後繼無力,NVIDIA看好逐漸在資料中心有所進展的Arm Neoverse微架構潛力,透過Arm Neoverse為基礎設計Grace CPU,既然自己投入CPU設計,自然就不用受限通用匯流排的限制,NVIDIA進一步透過晶粒對晶粒連接的NVLink-C2C技術使多個晶粒能夠透過高速通道連接。

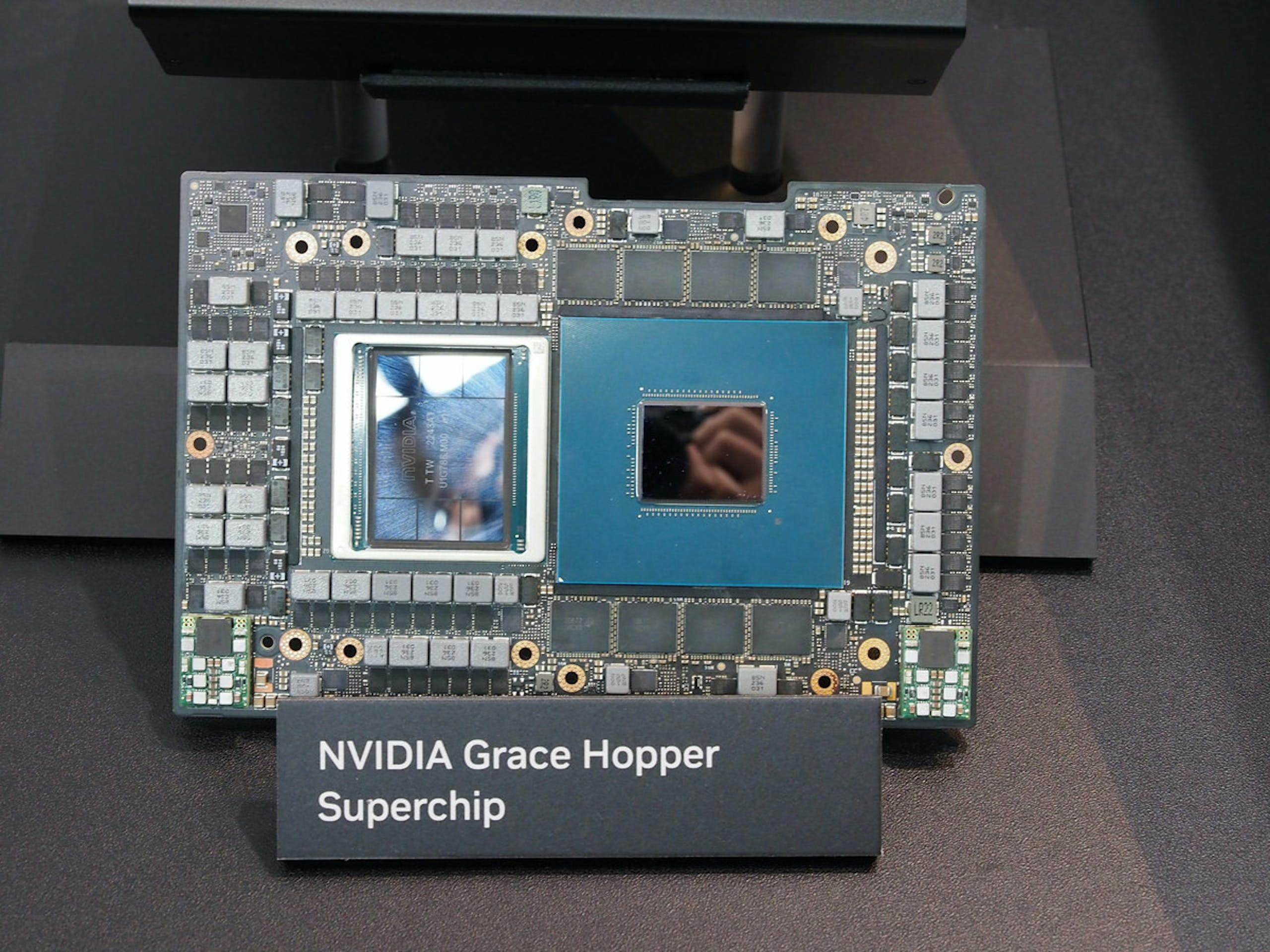

NVIDIA利用NVLink-C2C打造兩款產品,分別是雙CPU晶粒的Grace CPU Superchip,以及CPU+GPU的Grace Hopper Superchip。Grace CPU Superchip是因應傳統CPU運算需求而生,透過高速通道合併與共享兩個CPU晶粒的記憶體與算力;而Grace Hopper Superchip則是二度使CPU與GPU獲得雙向溝通與記憶體共享,但不同於Power時期透過NVLink需較大的占地面積,Grace Hopper Superchip在小巧的基板就具備相同的特質。

GTC 2022 : NVIDIA 發表新一代超算 GPU " Hopper " H100 與系統,並預告將結合 Grace CPU 構成 Grace Hopper 超級晶片

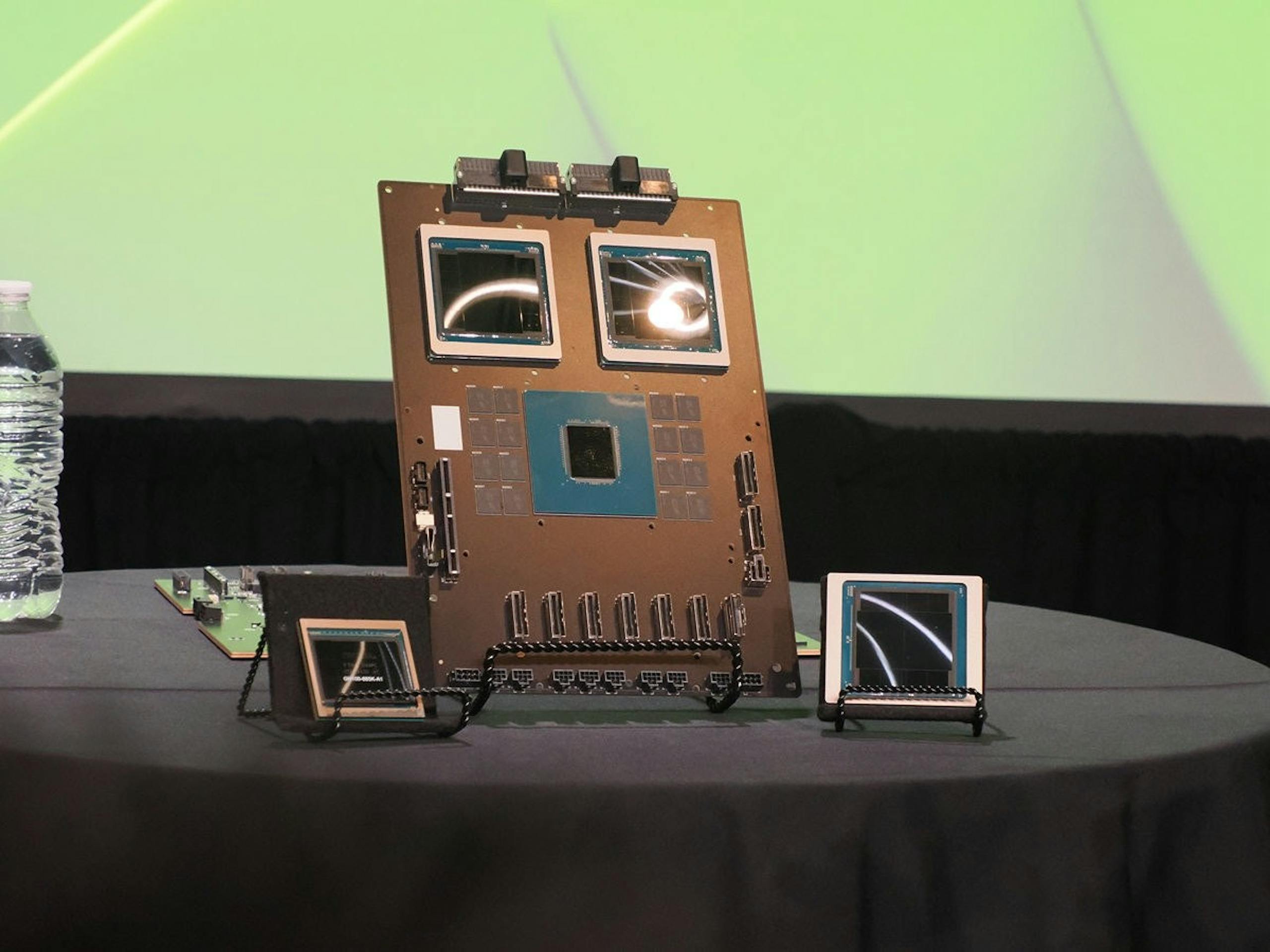

GTC 2023:Grace CPU架構火力全開降低對x86依賴

▲Grace CPU的出現也象徵NVIDIA積極降低對x86 CPU的依賴

GTC 2023是在疫情期間最後一次的全線上GTC大會,NVIDIA在此屆大會聚焦Grace CPU架構與相關產品,同時也正式宣布Grace CPU Superchip實體,強調其設計著重於單執行緒與記憶體處理,憑藉可安裝於1U風冷系統安裝兩組達144核CPU與1TB記憶體特性,資料中心可藉此最佳化整個資料中心吞吐量與總擁有成本,相較x86 CPU在於微服務更具效能與效率。

同時因應推論與大型語言模型需求,NVIDIA在GTC 2023宣布NVIDIA L4 Tensor Core GPU與NVIDIA H100 NVL加速模組,NVIDIA L4是針對推論基礎設施所提供的平台,能以極低的能號實現高效率的AI推論;而NVIDIA H100 NVL則是呼應大型語言模型需求,將兩張PCIe形式的H100加速卡透過NVLink連接,使其具備如同單卡96GB記憶體的加速卡,進而提供更充裕的運算效能與執行更大規模大型語言模型模型的推論。

同時隨著AI技術與GPU加速運算開花結果,2023年GTC大會也有多項有趣的進展,例如與ASML、台積電、Synopsys攜手透過NVIDIA cuLitho取代傳統以CPU執行的半導體運算式微影,藉此提升微影運算的效力;同時也與Quantum Machines合作推出DGX Quantum,使GPU加速運算能作為量子運算前其開發的跳板,開發結果亦能使用於原生量子運算硬體。

GTC 2023 : NVIDIA 公開展示 Grace Superchip 實體,強調低功耗且在微服務較 x86 具顯著性能與能耗效益

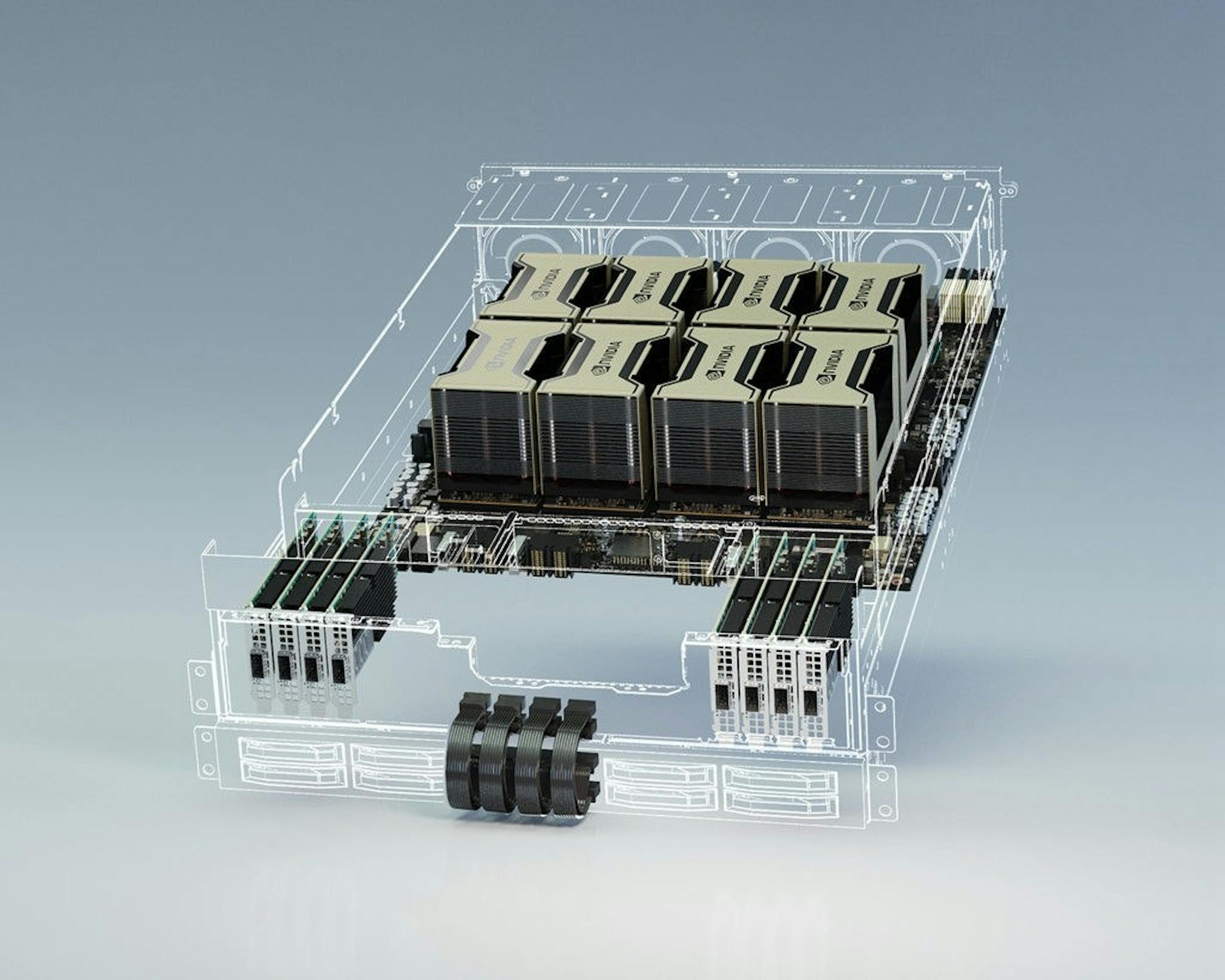

GTC 2024:再度拉開與競爭對手距離的Blackwell架構並可擴展至數萬GPU規模

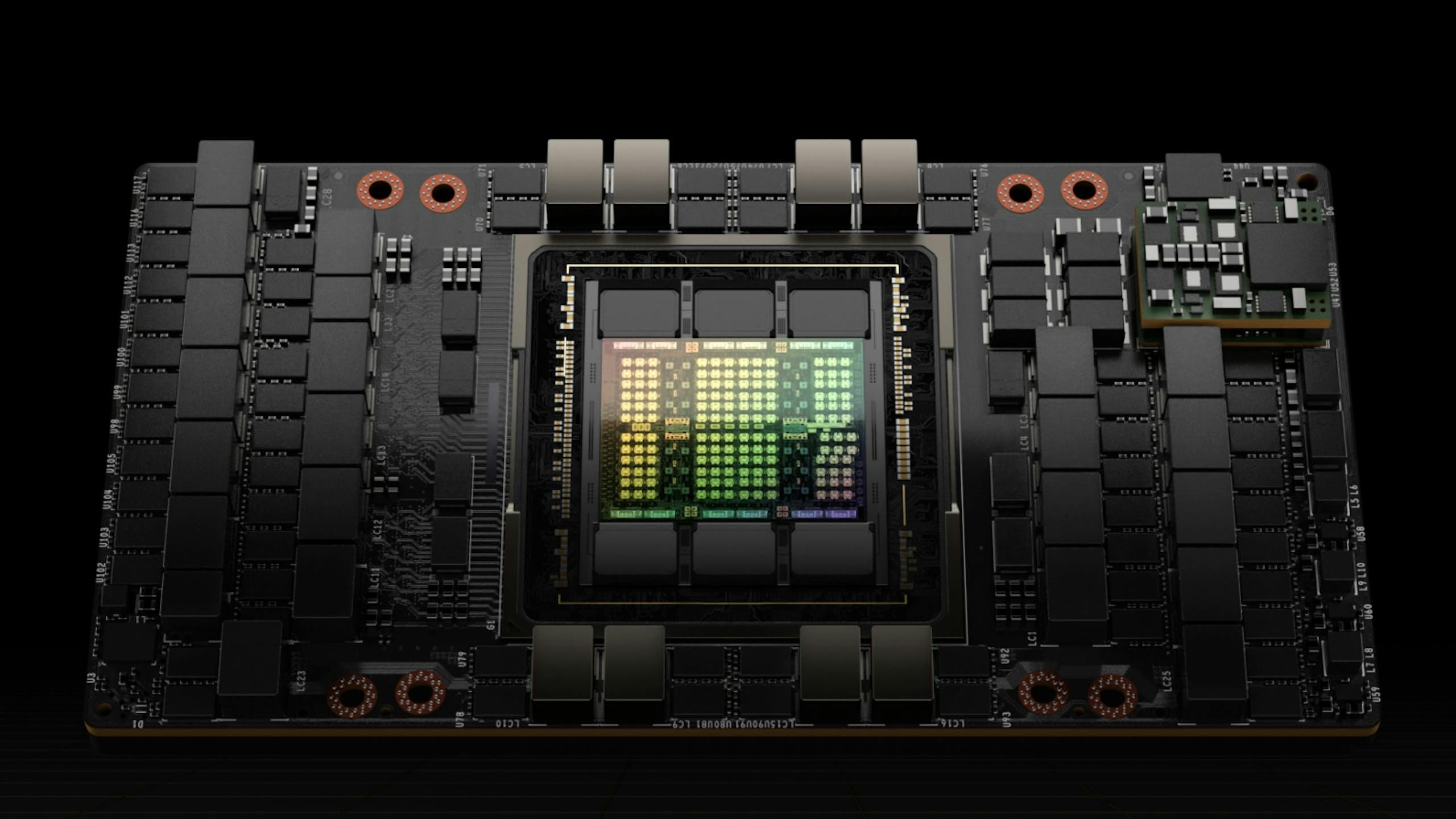

▲Blackwell與相關生態圈可說是NVIDA歷經10年發展GPU加速運算的集大成

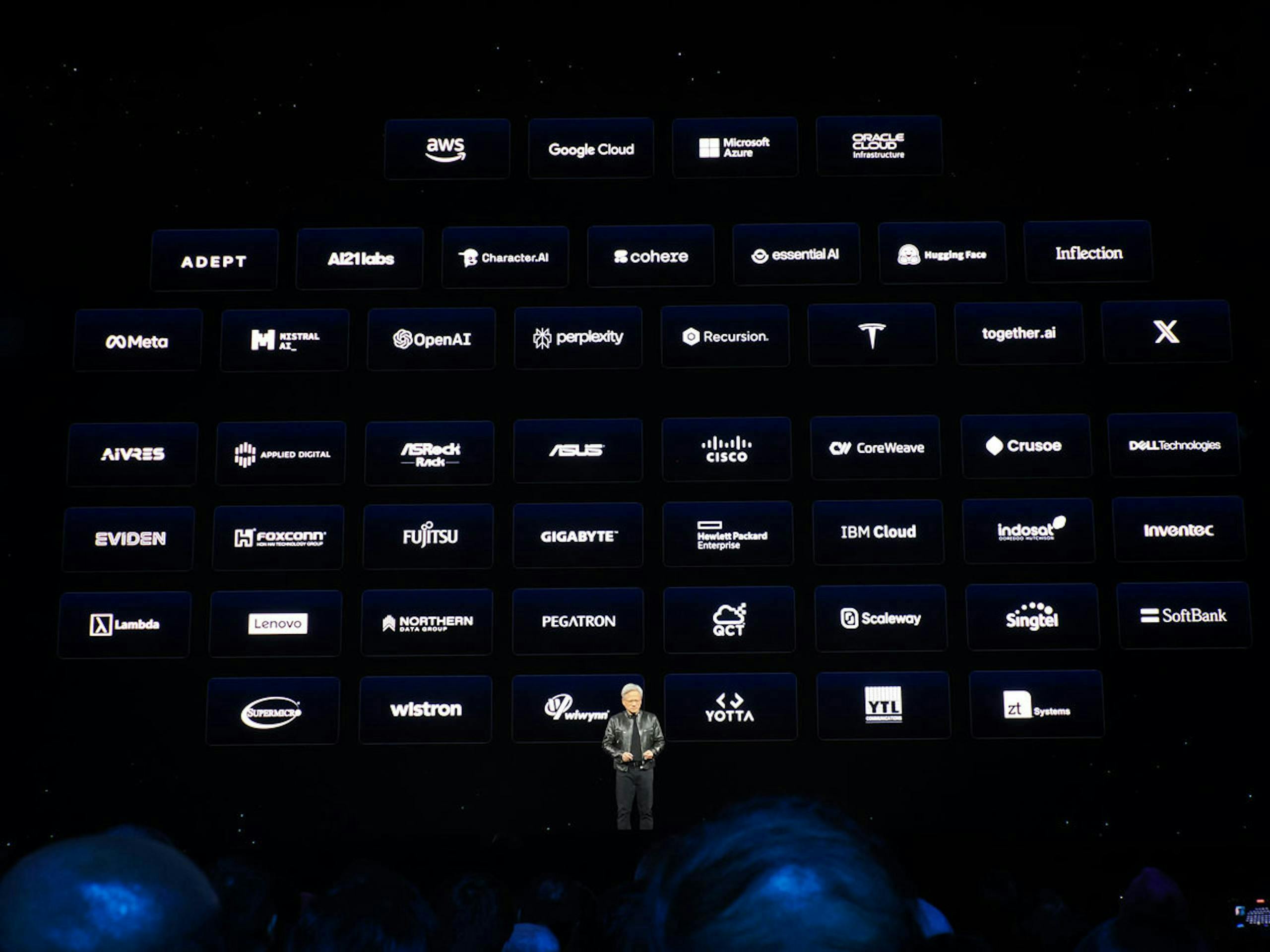

GTC 2024是Covid-19疫情後首度回歸實體舉辦的GTC,雖然同樣提供線上參加,但畢竟NVIDIA正在AI浪潮的勢頭,是歷屆以來參與者最多的實體GTC大會,報名參與人數突破1.5萬人;NVIDIA做為市場矚目的焦點,競爭對手也紛紛出招意圖將NVIDIA拉下王座,不過GTC 2024公布的Blackwell再度拉開與競爭對手的距離。

Blackwell可視為NVIDIA自Pascal公布以來的集大成之作,Blackwell承襲將近10年以來於加速運算、AI運算、高速互連技術的所有關鍵技術,同時也進一步利用小晶粒架構打造具備雙晶粒的NVIDIA B200 Tensor Core GPU,以及以1個Grace CPU搭配兩個B200 GPU的GB200 Superchip。

Blackwell具備第二代Transformer引擎,可透過微張量擴展支援與NVIDIA先進動態範圍管理演算法整合至NVIIDA TensorRT-LLM與NeMo Megatron框架,此外還支援FP4、FP6浮點,進一步支援更大規模的AI模型推論。同時也結合AI提供自我診斷能力,使系統能進行預防性診斷與可靠性預測,搶在發生狀況導致停機進行通報,進而降低系統營運成本。

不過要說Blackwell最大的爆點,莫過於基於GB200 Superchip的GB200 NVL72系統;由於GB200 Superchip原生支援NVLink技術,結合NVSwitch交換機後,單一機櫃可透過NVLink連皆高達72個GPU,使72個GPU宛若單一超大規模GPU,病最多能透過NVLink擴展到8套DGX GB200系統,同時透過Quantum-X800 InfiniBand與Spectrum-X800乙太網路平台能進行更多的系統節點擴充,結合網路架構、軟體與儲存可擴展到數萬GPU規模,使其足以執行兆級規模參數的AI模型。

這也意味著基於GB200的DGX SuperPod系統能夠突破以往x86架構單一節點最多8 GPU的限制,透過高速的連接網路進而擴展訓練與推論超大型模型的可能性,同時DGX GB200系統的關鍵元件也由NVIDIA一手包辦,除了Grace CPU、Blackwell GPU以外,還包括NVLink、BlueField DPU、Infinibald等,大幅降低對其它競爭對手的依賴。

GTC 2024:NVIDIA公布雙晶粒連接的Blackwell架構NVIDIA B200 Tensor Core GPU,GB200 Superchip由1CPU與雙GPU構成

回顧NVIDIA超越10年的歷程,從被視為一意孤行到眾星拱月的產業巨獸

12年的時光說長不長,但對於NVIDIA則是從CUDA加速運算被產業視為不可行、一路唱衰,但現在成為所有競爭對手都想挑戰霸業,但卻不得不與NVIDIA保持一定關係的現況;其中的關鍵是NVIDIA在發展的過程不僅專注於硬體的革新,同時也重視軟體工具以及透過開源方式加速產業應用與導入。

先前黃仁勳被問到CUDA是NVIDIA自有的技術,如何避免技術壟斷的疑慮,黃仁勳則表示「但是我們所有的軟體資源都是開源」以應對質疑;確實黃仁勳並未正面回應CUDA是目前NVIDIA技術護城河的疑慮,但是可理解透過軟體開源與持續與相關產業合作的方式,使得CUDA能夠成為當前無論是加速運算或是AI運算的關鍵技術。

▲DGX GB200 NVL72擴大GPU運算的可能性,並藉此迎接兆級參數模型世代

理想的狀況是透過開源的方式使不同的硬體都能進行加速與AI運算,但現實就是開源聯盟往往因為參與者難以放下身段相互妥協,都會希望保有自身技術的優勢與規範的主導權,最後導致開源規格窒礙難行;NVIDIA的CUDA雖是閉門技術,但卻也由於閉門簡化與軟體之間的相容問題,反倒促成基於CUDA的技術能夠容易使用並具備跨世代相容;同時NVIDIA更積極投入軟體升級,從每一版相關軟體仍能使相同硬體獲得提升不難看出NVIDIA投入在軟體的心力。

筆者倒也不是說競爭對手不重視軟體,只是相較之下曾直言「我們只有GPU」的NVIDIA把全部的心血都押寶在CUDA運算,雖在CPU至上的時代不被看好,但待到開花結果後,前期累積的資源加上後續仍持續投入軟體的升級與擴展,自然對於較晚才投入異構加速運算的對手難以迅速追上。

▲當前想挑戰NVIDIA霸業的競爭者不少,然而當前的NVIDIA是累積超過10年以上造就的成果

此外,NVIDIA在這十幾年以來於硬體的各項技術著墨,都是促成後續實現大規模GPU加速運算的關鍵;從投入NVLink連接使GPU能降低與CPU溝通,使多個GPU的運算資源與記憶體能夠並用,並為現今Grace CPU與GPU具備記憶體共享與雙向溝通鋪路,還促成晶粒對晶粒的高速連接

同時藉由收購Mellanox取得大規模佈署所需的高速網路與互連技術,NVIDIA也同時打通資料中心基礎不可或缺的節點互連與網路內運算技術,使NVIDIA自GPU供應者逐步成為提供圍繞在GPU為中心的資料中心軟硬體供應商的角色。雖然誰也說不準下一個10年會否風水輪流轉待到下一個王者崛起,但NVIDIA如今的成功絕非偶然,更多的是專注在認為可行的領域,並審視所需的關鍵技術不斷進行擴展與投資而來。

不過如同多年前GTC推廣加速運算時,曾有偏向遊戲娛樂技術的外媒語帶諷刺的對著黃仁勳表示:「Congratulation,NVIDIA is not a gaming company anymore」,相較2012年筆者首度深度接觸的NVIDIA,NVIDIA已不再是單純的顯示卡龍頭(當然目前顯示卡市佔率還是壓倒性的領先就是),NVIDIA的技術與產品已經複雜到筆者越來越難了解的產業巨獸。