NVIDIA在SC24大會宣布NVIDIA H100的強化版本NVIDIA H200 Tensor Core GPU,核心架構仍基於Hopper,主要在於提升記憶體的頻寬與容量,採用具備4.8TB/s頻寬、141GB的HBM3e記憶體,藉此提升整體算力;NVIDIA H200設計與NVIDIA H100具相容性,系統業者可沿用NVIDIA H100系統設計置換NVIDIA H200。

伺服器製造商與雲端服務業者預計於2024年第二季推出NVIDIA H200的系統與服務

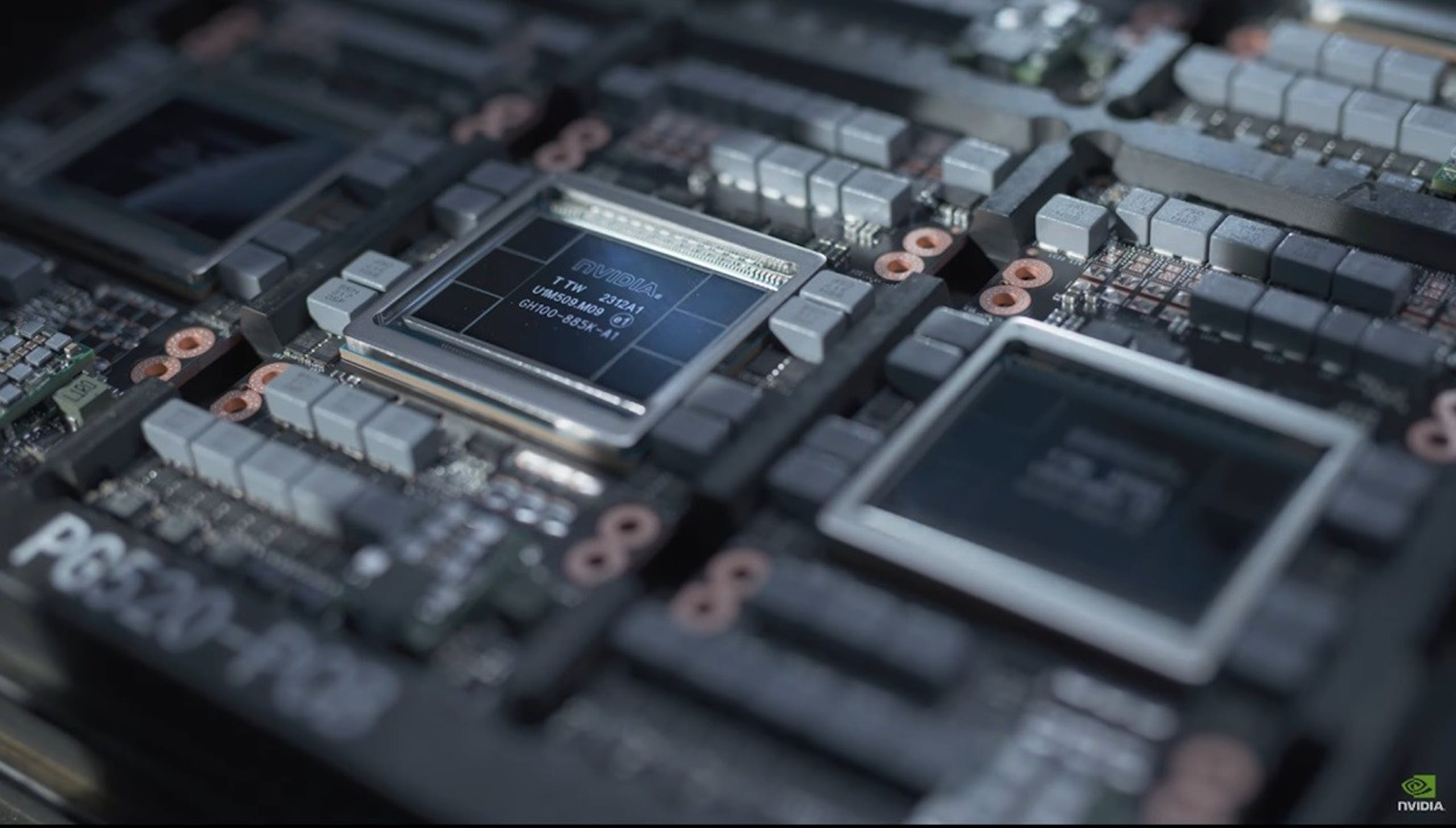

▲H200的晶片仍為H100,主要差異在於採用更大容量、更高頻寬的HBM3e記憶體

NVIDIA H200是首款配置HBM3e的GPU,HBM3e為NVIDIA H200帶來高達141GB的記憶體容量,與4.8TB/s的記憶體頻寬,相較NVIDIA H100容量幾乎翻倍、頻寬提升達2.4倍,對於生成式AI、大型語言模型還有HPU都有顯著的幫助;在實質上的表現,於GPT-3 175B的推論效能提升1.6倍,Llama2 70B推論提升1.9倍,HPC模擬則可提升2倍效能;NVIDIA也將持續透過軟體更新持續提升效能。

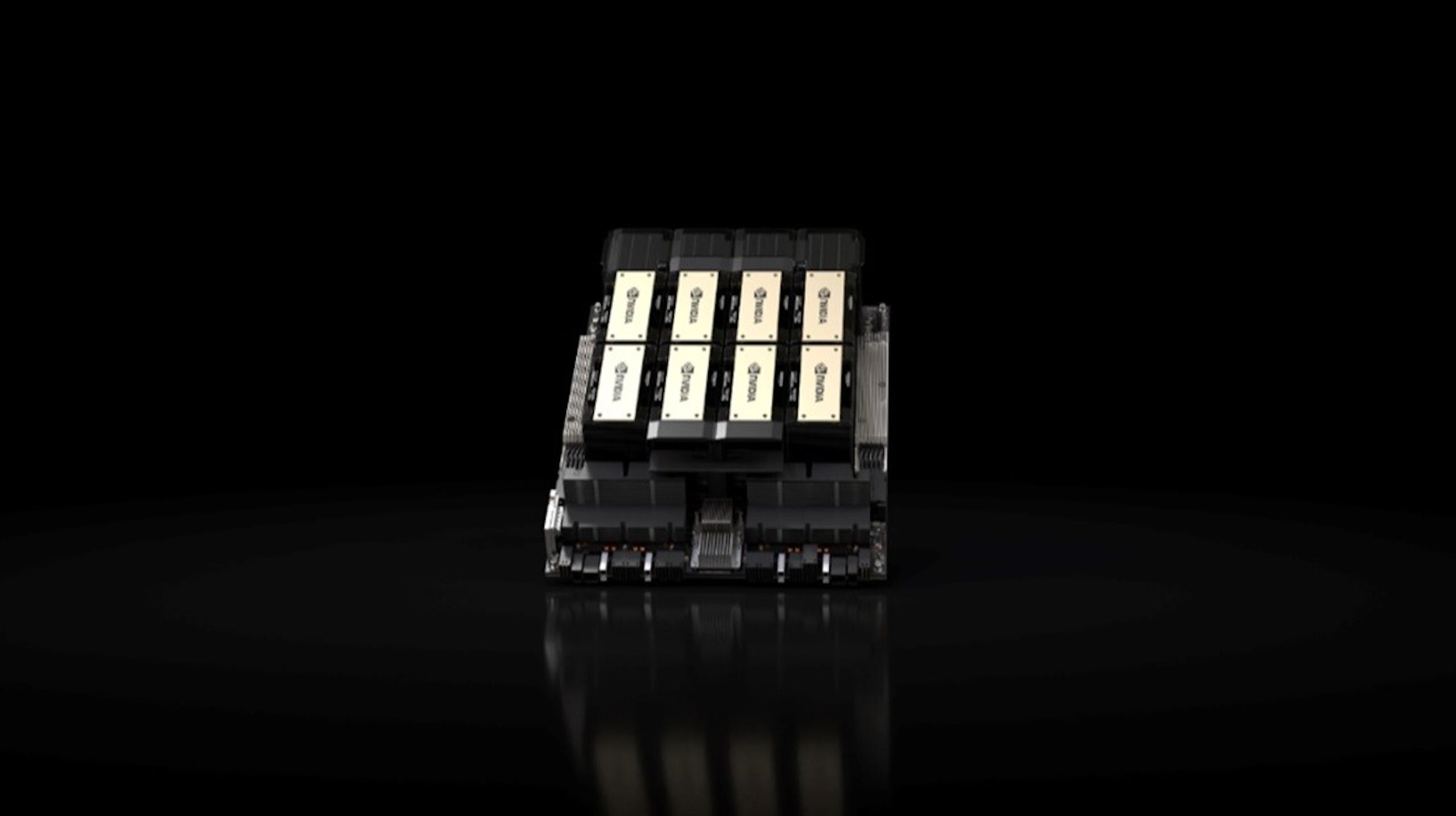

▲搭載8路H200的系統具備1.1TB的記憶體與 32petaflops的FP8效能,有助於執行生成式AI與HPC負載

NVIDIA H200將提供具4路與8路配置的NVIDIA HFX H200伺服器主機板,具有與JGX100系統的相容性,並亦可搭配同樣具備HBM3e的NVIDIA GH200 Grace Hopper SuperChip使用。基於8路HGX 200的系統可提供超過32 petaflops的FP8深度學習運算效能與高達1.1TB的HBM3e記憶體,有助於執行生成式AI與高效能運算,當搭配GH200時,則可做為大規模HPC與AI應用的整合模組。

全球生態系合作夥伴伺服器製造商,包括永擎電子、華碩、戴爾科技集團、Eviden、技嘉科技、慧與科技、鴻佰科技、聯想、雲達科技、美超微、緯創資通和緯穎科技,都可以使用基於H200的直接替換方式來更新其基於H100 的系統。除了CoreWeave、Lambda 和 Vultr之外,從明年開始,亞馬遜網路服務、Google Cloud、Microsoft Azure和Oracle Cloud Infrastructure也將成為第一批部署基於 H200 執行個體的雲端服務供應商。