Google Cloud 於 Cloud Next '23 宣布擴大與 NVIDIA 合作關係,除了 Google C;loud 在一系列服務導入 NVIDIA 加速硬體、在 Google Cloud 提供 NVIDIA DGX Cloud 、於 Google Cloud Marketplace 提供 NVIDIA AI Enterprise 以外, Google 用於建立大型語言模型( LLM )的 PaxML 框架也針對 NVIDIA 加速運算進行最佳化,不再僅限於 Google TPU 執行。

▲ PaxML 原是為跨多個 Google TPU 加速器切片建構的開發框架,現在可在 NVIDIA 加速運算技術執行

PaxML 原本是 Google 為跨多個 Google TPU 加速器切片建構的大開發框架,經過雙方的合作,現在開發者能於 NVIDIA H100 、 NVIDIA A100 兩款 Tensor Core GPU 執行先進且可完全配置的實驗與規模,同時 NVIDIA NGC 軟體目錄也開始提供 GPU 最佳化的 PaxML 容器供全球研究人員、新創公司與企業;同時 PaxML 可在 JAX 執行, JAX 亦已針對 OpenXLA 編譯器的 GPU 優惠; Google DeepMind 與 Google 研究人員將是首批使用 PaxML 與 NVIDIA GPU 進行探索研究的團隊。這也顯見 NVIDIA 在多年的 GPU 加速軟硬體投入之下,能廣泛支援多種類型的 AI 技術,同時不遜於專用加速器,也是部份針對特定 AI 技術的專用加速器之所不及的。

此外,雙方也宣布 Google 透過 Google Dataproc 服務將無伺服器 Spark 與 NVIDIA GPU 整合,將幫助資料科學家加速 Apache Spark 工作負載,藉此準備進行 AI 開發所需資料。

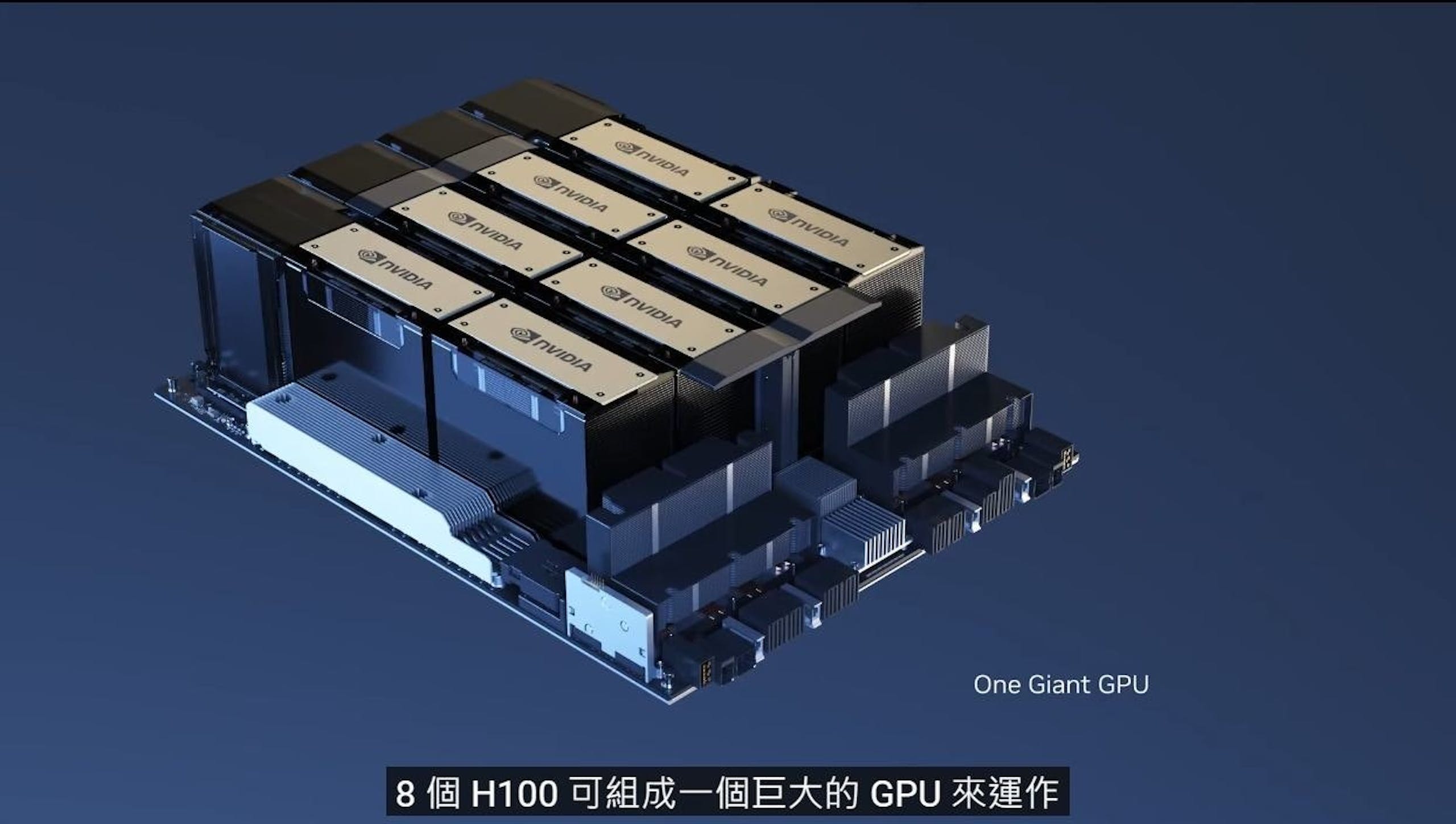

此外 Google Cloud 也同步宣布多項雙方合作的軟硬體,包括 Google Cloud 將自 9 月起於專為 NVIDIA H100 建構的 A3 虛擬機器提供 NVIDIA H100 服務,相較前一代可提升 3 倍訓練速度以及更優異的網路頻寬;同時 Google 的 Vertex AI 預計在幾周後陸續提供 NVIDIA H100 ,將協助客戶更快速開發生成式 AI 基礎的大型語言模型;另外 Google Cloud 也將成為首波導入 NVIDIA DGX GH200 的公司之一,將使用戶使用結合 CPU 、 GPU 之記憶體共享互聯的 NVIDIA Grace Hopper ,用於探索生成式 AI 工作負載。同時 Google Cloud 也將成為 NVIDIA DGX Cloud 的服務供應商之一,使客戶能使用具安全、簡化開發與部署企業級應用程式的雲原生軟體平台,提供自生成式 AI 、語音人工智慧至電腦視覺服務;最後 Google Cloud 已在日前宣布於 G2 虛擬機器提供 NVIDIA L4 Tensor Core GPU ,將在虛擬桌面基礎設施與基於 AI 的音訊、影片轉檔獲得顯著的加速。