當前 HBM 記憶體成為 HPC 與 AI 頂級硬體的熱門記憶體規格,美光 Micron 宣布推出新一代的 HBM3 Gen 2 記憶體,初步推出 8 層堆疊的 24GB HBM3 Gen 2 記憶體,預計 2024 年再公布 12 層堆疊的 36GB HBM3 Gen 2 ;美光 HBM3 Gen 2 每腳位傳輸速率超過 9.2GB/s 、較目前市面上 HBM3 方案高出 50% 以上,並達到 1.2TB/s 以上頻寬,同時每瓦效能提升 2.5 倍。

美光 HBM3 Gen 2 將提升 AI 數據中心的關鍵性能、容量與功耗指標,並有助縮減如 GPT-4 等大型語言模型( LLM )與未來更高階版本的訓練時間,在提升 AI 基礎硬體性能之餘提供卓越的總體擁有成本。

▲美光先推出 8 層堆疊的 24GB HBM3 Gen 2 ,預計 2024 年送樣 12 層堆疊、 36GB 版本

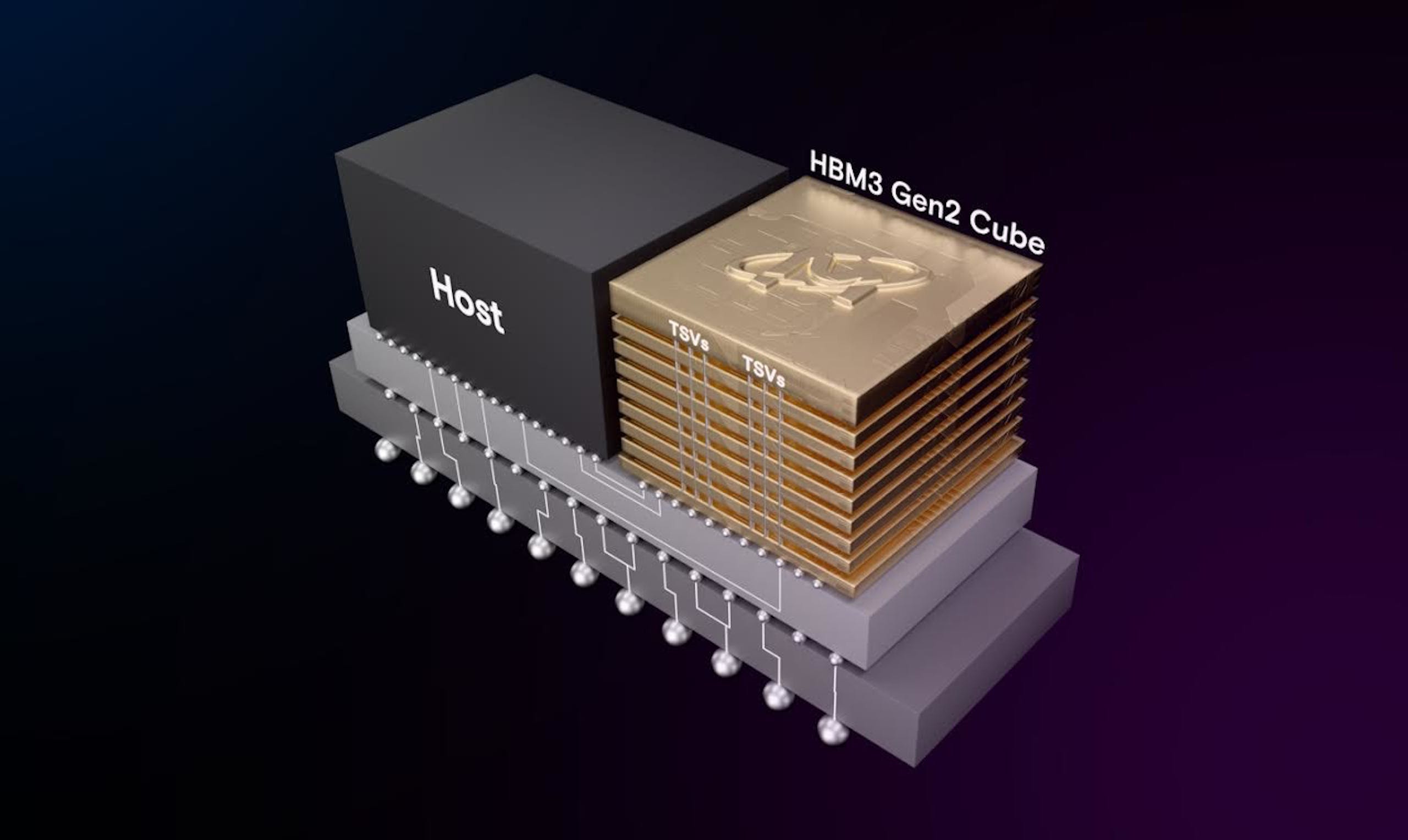

美光 HBM3 Gen 2 採用 1β DRAM 製程節點,將總共 24GB 晶粒以堆疊 8 層高度方式構成立方體,同時也將於 2024 年送樣 12 層的 36GB HBM3 ,將可比競品高出 50% 容量。美光在 HBM3 Gen 2 透過比當前 HBM3 高出一倍的矽晶穿孔數量,以及以五倍金屬密度減少熱阻抗,藉此實現低功耗。美光透過參與台積電 3DFabric 聯盟夥伴,與台積電導入與整合 AI 及高效能運算設計的運算系統,台積電當前已收到美光 HBM3 Gen 2 樣品並進行評估與測試。

在當前最熱門的生成式 AI 技術,美光 HBM3 Gen 2 的高頻寬與容量發揮關鍵效用,每組堆疊達 24GB 容量、每腳位大於 9.2GBps 的傳輸速度能減少 30% 大型語言模型的訓練時間,除了降低總體持有成本,也能提升每日查詢次數;此外由於優異的每瓦效能,已裝設 1,000 萬個 GPU 計算,每組爹蝶能減少 5W 效能、在 5 年使用可省下達 5.5 億美金的營運成本。