AMD 在 2023 年 6 月中資料中心發表會的重頭戲,即是宣布全新的 Instinct 300 系列加速器產品,除了已於 CES 預告的首款資料中心級 APU 產品 Instinct MI300A 以外,還有鎖定生成式 AI 需求、高達 192GB HBM3 記憶體的 Instinct MI300X 加速器; Instinct MI300A 與 Instinct MI300X 皆採用小晶片設計,混合 5nm 與 6nm 製程晶粒。以產品特質而言, Instinct MI300A 與 Instinct MI300X 頗有與 NVIDIA 的 Grace Hopper Superchip 與 NVIDIA H100 戶別苗頭的味道。

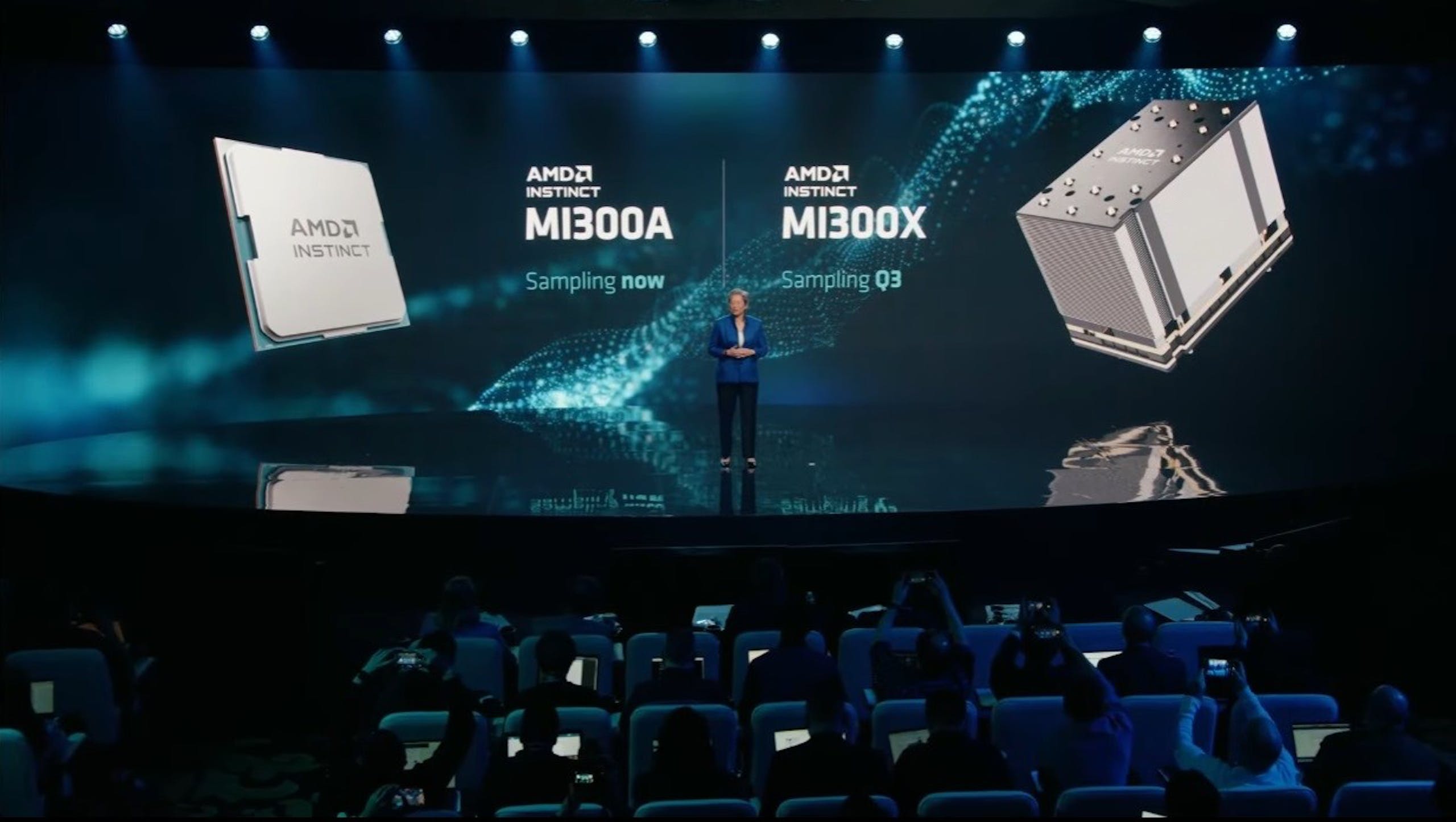

▲ Instinct MI300A 與 Instinct MI300X 將陸續提供樣品,並於 2023 年第四季量產

AMD 已經開始為客戶提供 Instinct MI300A 的樣品,而 Instinct MI300X 則將在 2023 年第三季提供樣品; Instinct MI300A 與 Instinct MI300X 皆將在 2023 年第四季量產。

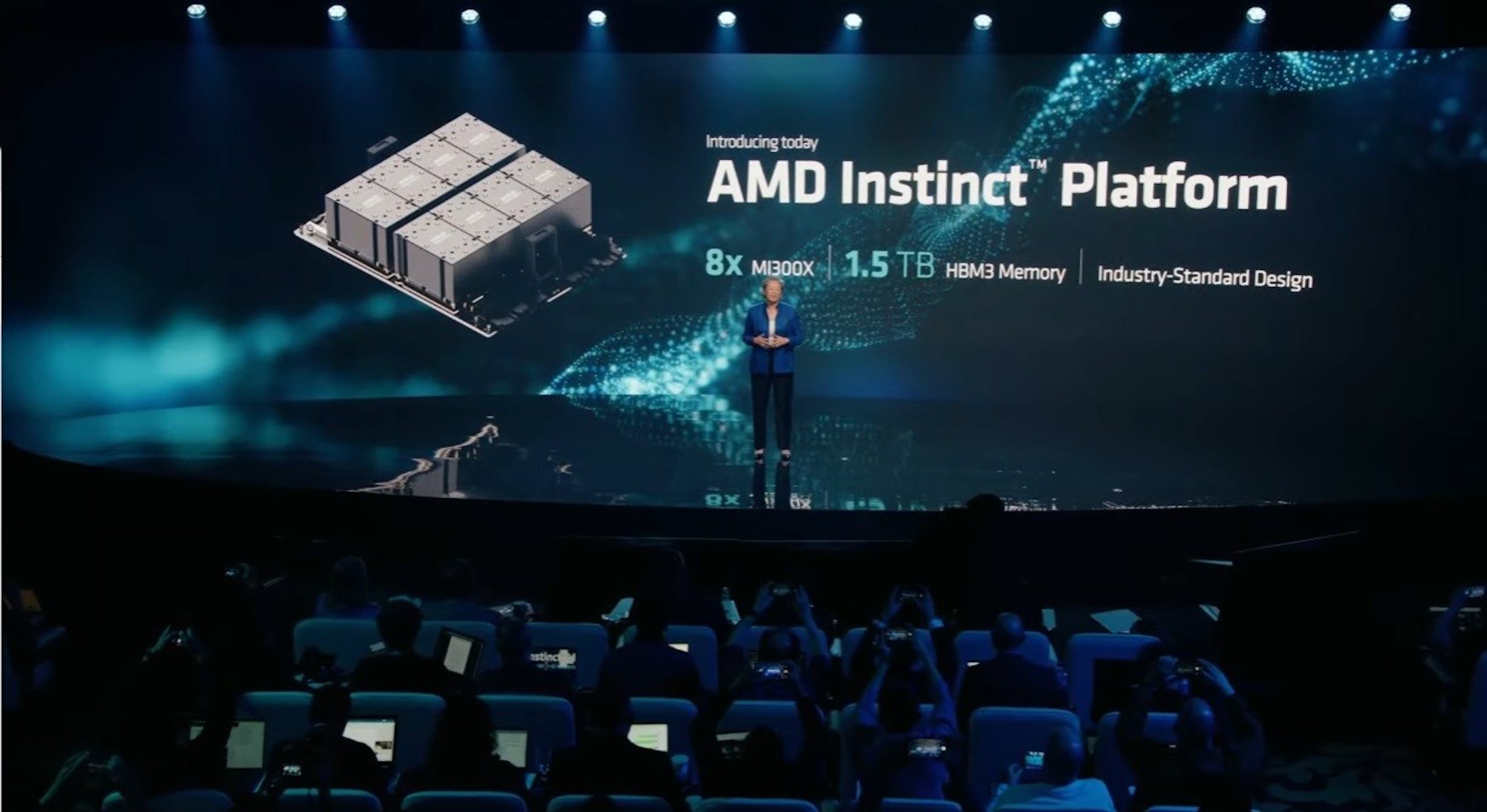

AMD 將提供達 1.5TB 記憶體的 AMD Instionct 加速平台

▲ AMD Instinct 平台由 8 張 Instinct MI300X 構成,依循 OCP 開放伺服器平台標準

此外, AMD 也同步公布稱為 AMD Instinct 平台的設計,由 8 張 Instinct MI300X 構成,具備達 1.5TB 的記憶體,同時強調其設計依循產業標準的 OCP 開放伺服器平台標準。其設計近似 NVIDIA 的 NVLink 基板設計,不過在活動上 AMD 並未針對連接技術做進一步的介紹。

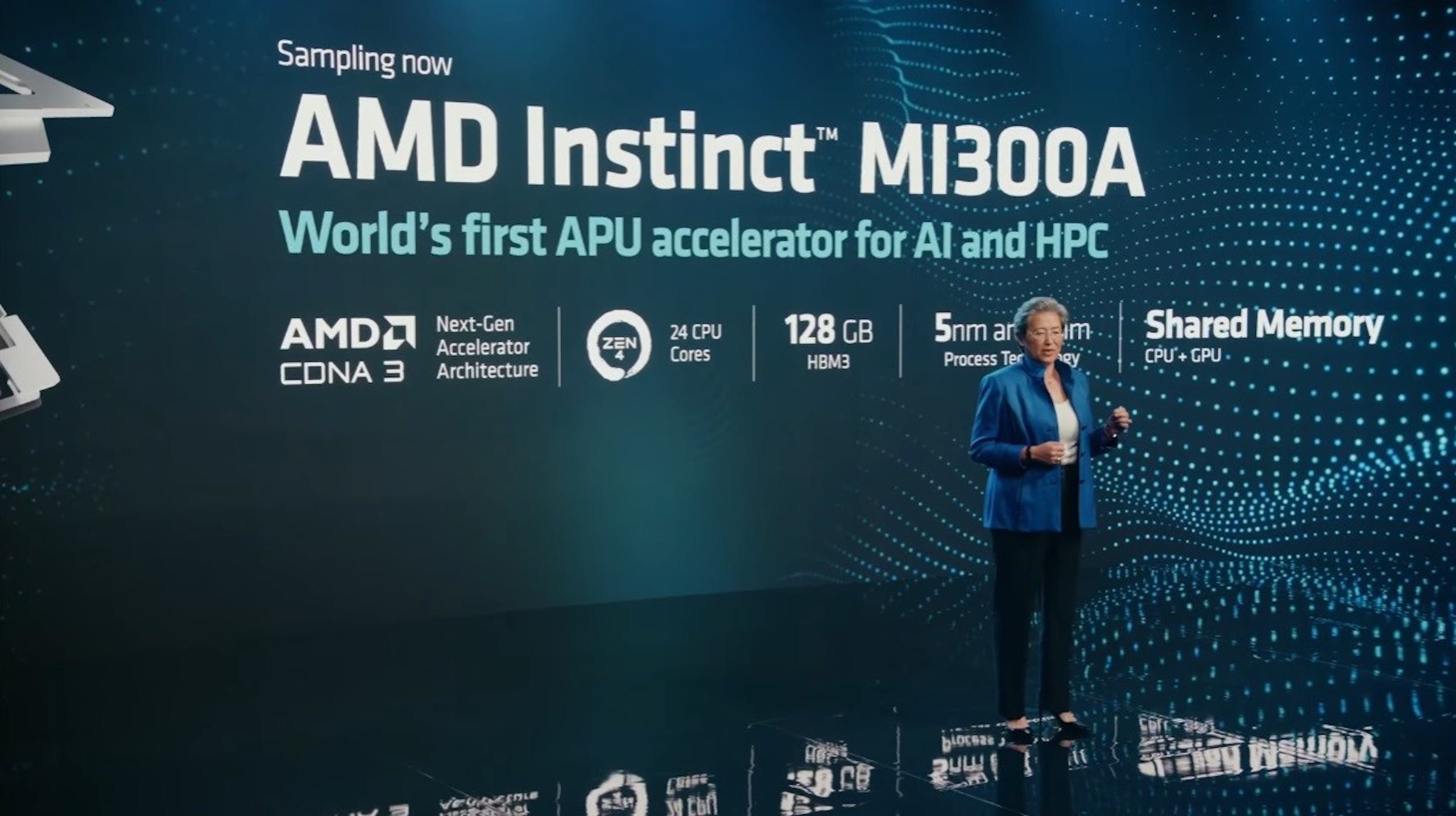

AMD Instinct MI300A 是第一款為 AI 與 HPC 設計的 APU

▲ Instinct MI300A 由 24 核 Zen 4 與 CDNA3 GPU 構成

AMD Instinct MI300A 是 AMD 首度將 APU 產品擴大到 AI 與 HPC 領域,採用 24 核 Zen 4 架構與 AMD CDNA3 加速架構以小晶粒的方式組成;相較消費級的 APU 產品, Instinct , Instinct MI300A 採用 CPU + GPU 統一記憶體架構,配有 128GB 的 HBM3 記憶體,使單一異構晶片的 CPU 與 GPU 能直接存取彼此運算的結果。

AMD Instinct MI300A 與同樣採用 CPU 與 GPU 統一記憶體的 Grace Hopper Superchip 在記憶體概念有極大的不同。 AMD 選擇全部採用高速、高成本且相對容量較小的 HBM3 記憶體;而 NVDIA 則是在 CPU 區塊使用節能、容量價格優勢的 LPDDRX , GPU 再採用 HBM3 記憶體,彼此透過達 900GBs 的 NVLink-C2C 高速通道進行共享。

Instinct MI300X 為挑戰 NVIDIA H100 霸業而來

▲ Instinct MI300X 配有巨量的 192GB HBM3 記憶體

Instinct MI300X 是 AMD 用以挑戰 NVIDIA 在生成式 AI 霸業而來的加速器產品,基於 AMD CDNA3 的小晶片架構,利用 896GB/s 的 Infinity Fabric 相互連接,配有高達 192GB 的 HBM3 記憶體,記憶體頻寬達 5.2TB/s ;等同單一 Instinct MI300X 加速卡即有超越兩張 NVIDIA H100 的記憶體容量(註:即便是雙卡連接的 H100 NVL 總記憶體也僅有 188GB ),對於日益龐大的大型語言模型( LLM )與生成式 AI 而言,大容量記憶體的優異也不必多說,且在串接 8 張後可在 AMD Instinct 平台實現 1.5TB 的容量。

2 則回應