NVIDIA 執行長黃仁勳在年度活動 GTC 2023 時,提出現在將是 AI 的「 iPhone 時刻」的論調,對於以 GPU 異構加速運算將 AI 從僅有基本功能發展至現在看似蓬勃發展現況的 NVIDIA ,貌似 AI 的「 iPhone 時刻」早已開始,為何黃仁勳現在再度提出接下來才是 AI 的「 iPhone 時刻」的論點。

所謂的「 iPhone 時刻」指的是如當年在 iPhone 之前早已有智慧手機(如 Nokia Symbian 、 Windows Phone 等),但智慧手機真正奠定現在所認知的特性、功能卻是直到蘋果推出 iPhone 後才有了雛形,同時也帶動智慧手機的積極發展,這些由 iPhone 奠定的智慧手機基礎最終促成智慧手機取代功能手機成為手機的主流發展型態。

▲ iPhone 借助直觀的人機介面與觸控,使智慧手機成為簡單易用的設備並奠定現代智慧手機的基礎

同時, iPhone 也顛覆在此之前智慧手機對一般使用者門檻過高、以觸控與直觀的使用者介面使人人都能輕鬆使用各項功能,此外藉由高度的整合,使手機不僅只是手機。對於當前的 AI ,以 ChatGPT 為首的自然語言理解也將會使 AI 能夠廣泛被大眾輕鬆使用,不再僅限於特定領域專家才能駕御。

雖然透過 GPU 加速運算的 AI 相較傳統 AI 已經有顯著的突破,然而黃仁勳認為現行 AI 將進入「 iPhone 時刻」的關鍵則在於大型語言模型 LLM 得以擴展且實用化,其中的關鍵即是由 Open AI 展示 ChatGPT 對於各領域應用的可能性;雖然單就文字敘述,語言認知領域的應用應該是以聲音與文字為主,但實際上語言領域是許多重要應用的基礎。

▲大型語言模型不僅使用在語意理解,更延伸到包括生醫研究、影像生成等領域

雖然一般會說人是視覺的動物,但實際上,人是透過各種感官接收資訊,再透過思考邏輯進行轉化,作為思考邏輯基礎的即是語言;人類在接收到資訊後,首先會將其轉化為自身認知的語言再進行各種類型的延伸,而人工智慧( AI )也依循相同的原則,藉助各式感測器接收資訊,無論是文字、聲音、影像,再將資訊轉化為各種的文字敘述,後續再將其進行反向輸出。

當前許多的 AI 應用的背後都是透過敘述(文字)為基礎進行,例如現在智慧手機的照片影像增強,即是透過辨識技術拆解圖像的元素,將其對照到符合的情境(如日出、晴空、陰天)或是物件(如人物、動物、車輛)後,再透過資料庫當中對於不同特性的處理方式進行增強;而近期熱門的 AI 繪圖也是依循相近的原理,先理解使用者的語意後,再從 AI 模型當中融合這些條件產生影像。

▲在無法理解正確語意的情況,就會產生荒謬且嚴重錯誤的結果

雖然對於人類而言,語言與語意是一種自然行為,但透過 AI 進行語意理解是一件極其複雜的事物,因為自然語言的形成是相當複雜的一件事情,是經過日積月累而來,同時還會因為不同的時空背景產生分歧,最簡單的例子就是不同國家的語言,若未經過學習是難以直接理解的,縱使理解字面上的意義,但項是俚語、成語或是隱喻或是地方方言,又需要更深層的語言認知才能理解。

從語言了解到語意理解需要複雜的資料庫進行訓練完成 AI 模型,也就是當前 AI 產業提及的大型語言模型 LLM ( Large Language Model ),不過以往進行 LLM 訓練時,不光只是訓練模型所需的算力,對於 GPU 異構而言,更頭痛的還有記憶體容量的問題,故 NVIDIA 在多年前就積極地進行布局,不光只是引進大容量的高速記憶體,同時還有加速跨晶片溝通的 NVLink 技術。

▲因為通用高速連接介面發展速度無法滿足 NVIDIA 對多晶片溝通的需求,是故自行發展 NVLink 與相關延伸技術

NVLink 的出現是為了消弭典型運算架構中過於側重 CPU 、將 GPU 作為附庸,以及受到 PCIe 通道的規範演進速度過慢的問題;畢竟作為完整的 PC 系統仍需要 CPU 運作,在 GPU 運算的資料仍須回傳至 CPU 處理,故 NVIDIA 的作法是盡可能減少資料之間反覆傳輸,同時還有盡可能擴大 GPU 的記憶體,於是藉由自定義的高速通道技術一舉解決這些問題。

藉由 NVLink 提供較同期 PCIe 更快的通道速度,能夠使 GPU 與 GPU 之間利用高速通道連接並共享記憶體,使多個 GPU 被 CPU 視為一個單一的大型 GPU ;當然 NVLink 更初期也希冀顛覆 CPU 與 GPU 的單向溝通模式,不過畢竟 NVIDIA 在當時未有發展 CPU , AMD 與 Intel 並未支援 NVLink 技術,僅有 IBM Power 與其合作,但畢竟 IBM Power 並非主流 CPU 架構,也使得 NVLink 僅在少數系統實現多向溝通的能力。

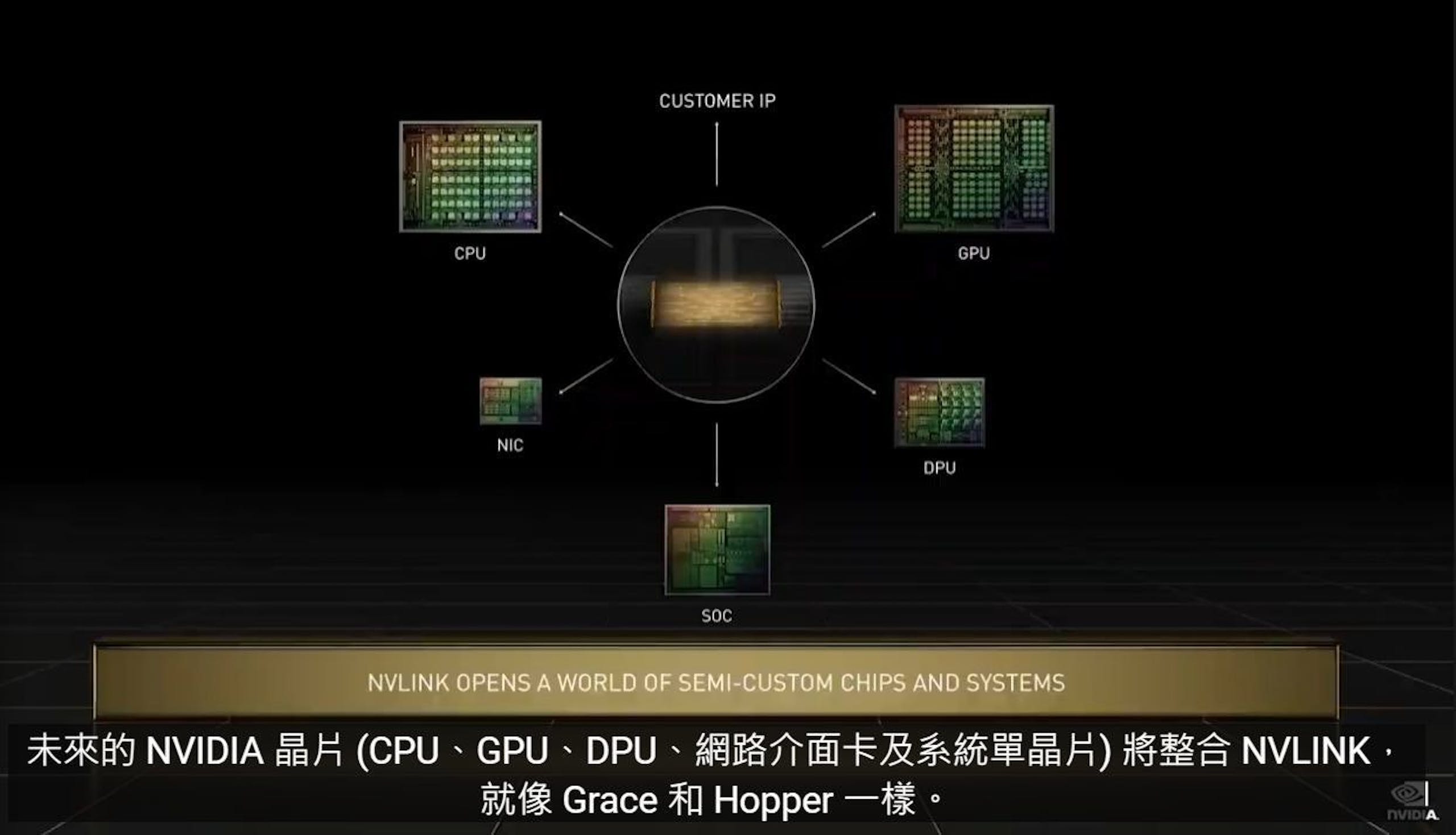

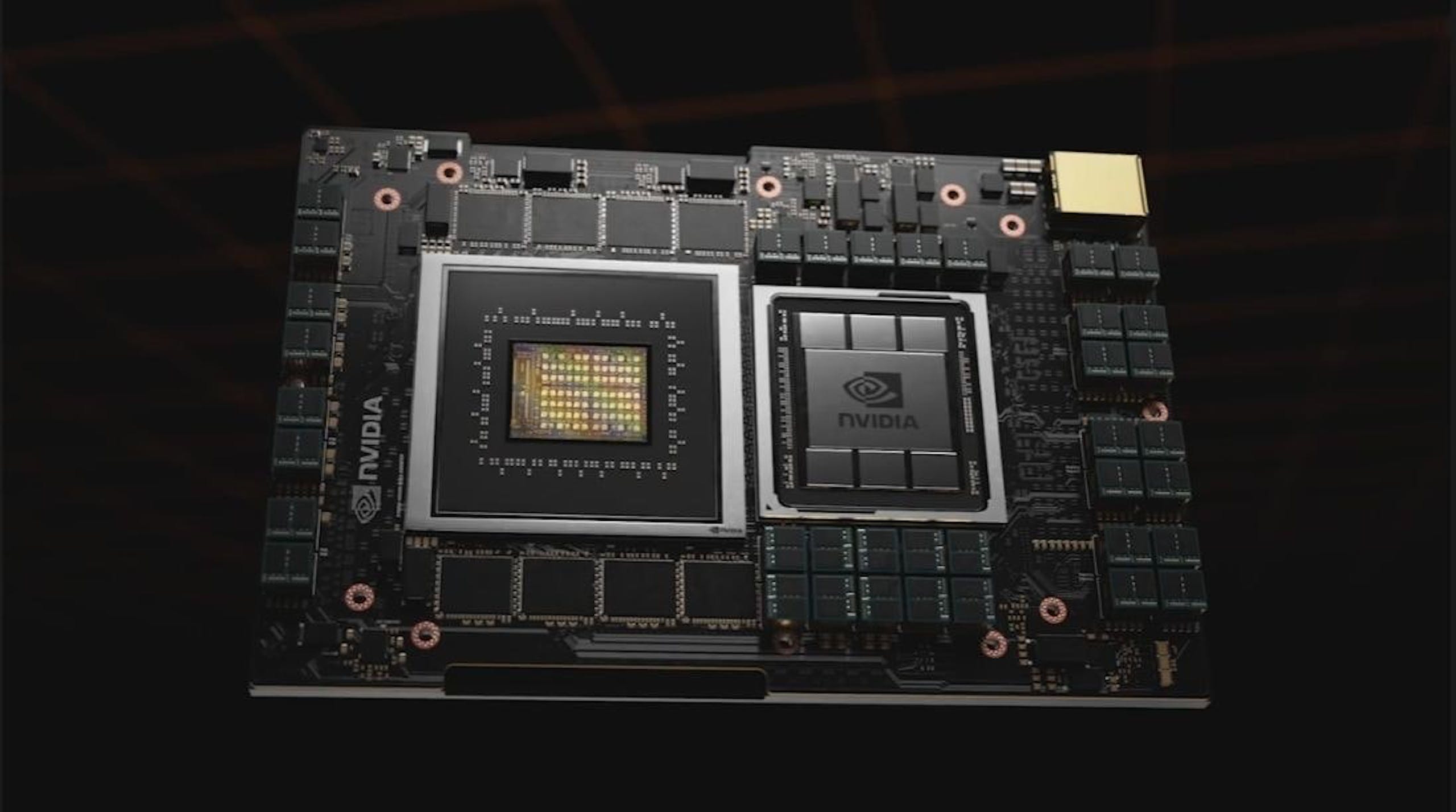

不過隨著技術的演進,後續包括在同一個迴圈能夠容納更多 GPU 的 NVSwitch 閘道技術,以及晶粒對晶粒級的 NVLink-C2C ,還有 NVIDIA 以 Arm Neoverse 為基礎開發的 Grace CPU 的誕生,進一步實現 NVIDIA 對異構加速運算所勾勒的藍圖,同時未來 NVIDIA 亦打算透過 NVLink-C2C 提供客製化架構設計,也進一步為異構加速運算提供更多的願景。

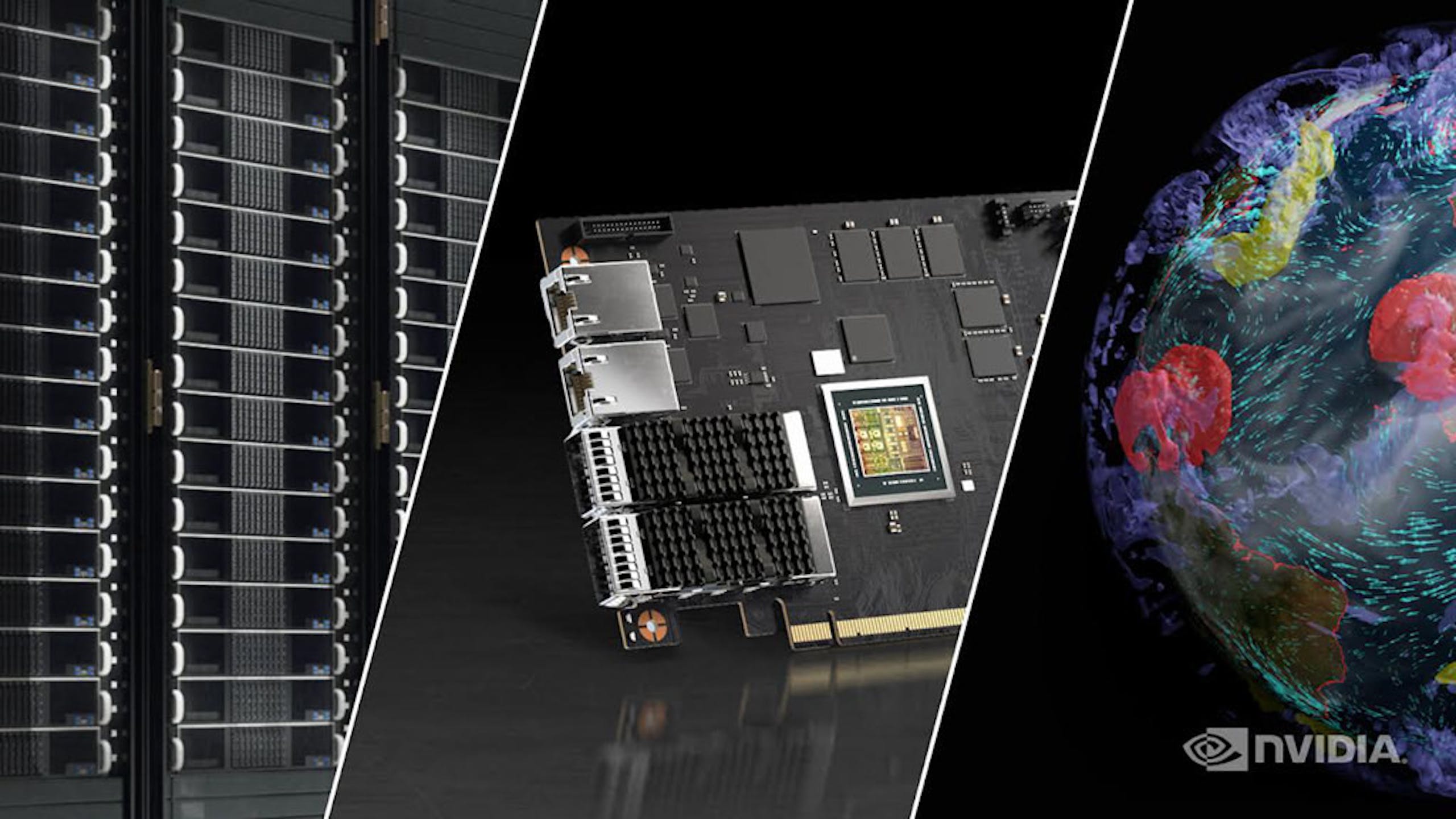

▲收購 Mellanox 是使 NVIDIA 進一步取得高速網路互連的戰略布局

同時, NVIDIA 藉由收購提供 Infiniband 技術的以色列 Mellanox 取得系統對系統的高速互聯技術,並進一步結合 NVIDIA 的 GPU 加速技術打造一系列的 DPU 產品,藉此使跨系統之間的溝通更具效益,同時進一步擴大「單一大型 GPU 」的理念,使多個系統的連接的反應速度趨近於在單一系統執行。

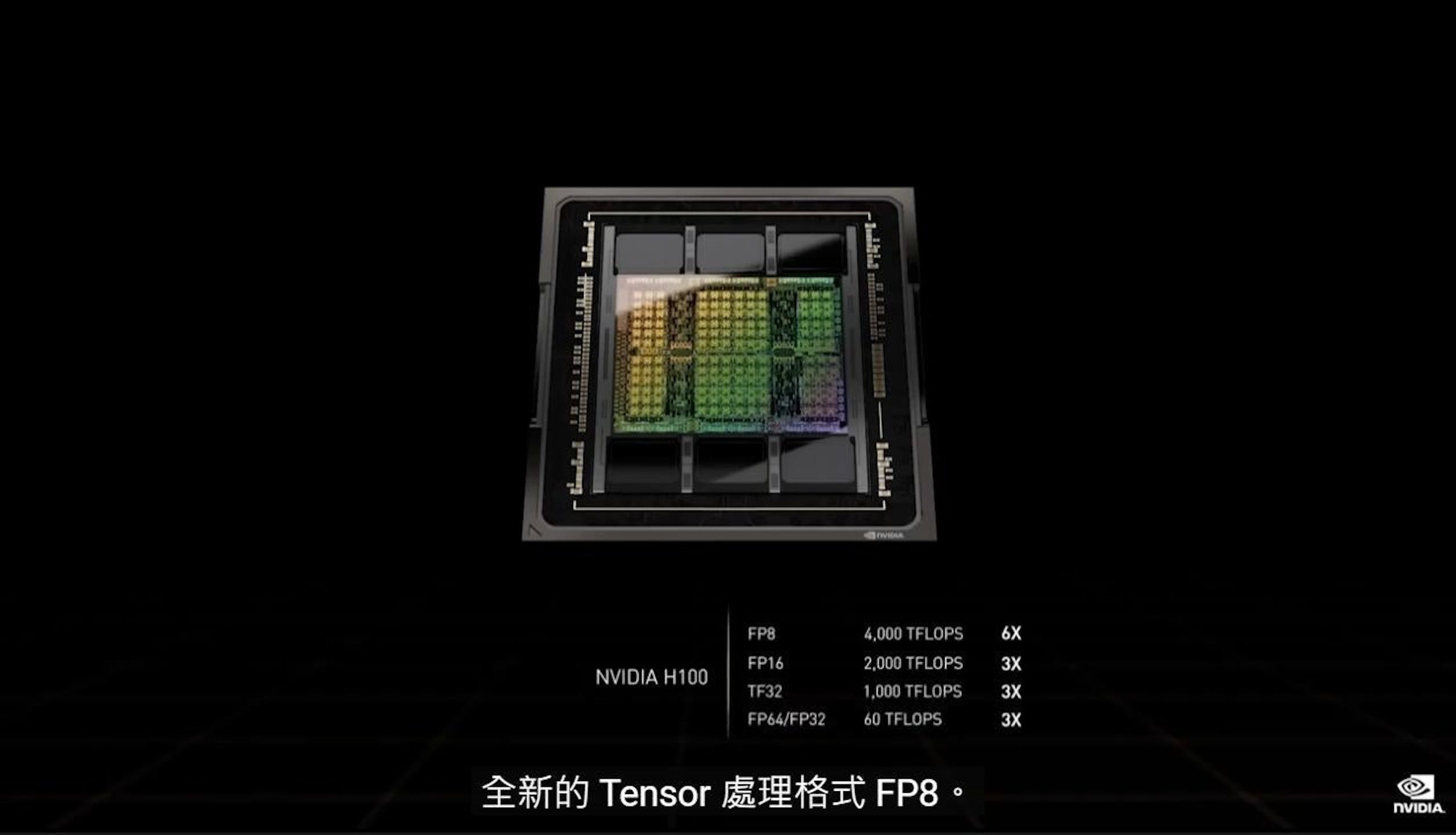

▲借助支援 FP8 與 Transofrmer Engine ,不僅加速訓練的效率同時在推論階段也不須將模型進行轉化

同時, NVIDIA 的專業加速產品亦逐世代因應產業變化而進化,最新一代的代號 Hopper 的 NVIDIA H100 除了升級加速器架構,還增添 Transformer Engine 與對 FP8 精度的支援,透過可應用混合 FP8 與 FP16 的第四代 Tensor Core , Transformer Engine 透過動態使用 16bit 浮點精度與新增的 8bit 浮點資料格式,藉由將人工智慧的數學運算降至 8 位元,大幅提升在人工智慧神經網路的訓練速度,同時保有與 16bit 相當的精度。

另外在推論領域,相較於前一代 NVIDIA A100 所支援的 INT8 需將訓練後神經網路轉換為 INT8 格式, NVIDIA H100 的 Transformer Engine 的 NVIDIA TensorRT 推論優化器可在不需進行資料轉換的前提進行推論,開發者可直接透過 FP8 進行模型訓練並維持相同的精度進行推論,並保有與 INT8 使用更少記憶體的優點。

▲簡單易用易取得,才能促使開發者願意投入

不過支撐強大的硬體運算力的關鍵,則是 NVIDIA 持續強化的軟體與開發環境戰略布局,因為再強大的硬體若沒有友善的開發環境也難以成形,舉個遊戲玩家可能比較熟悉的例子,就是 Sony 的 PlayStation 3 的發展史, Sony 當時大膽採用超算級的 Cell 處理器,然而由於硬體領先世代太多,上市初期甚至幾家作為首發技術展演的夥伴因為開發遊戲過於燒錢而倒閉,直到後期開發環境與商用遊戲引擎的支援才陸續獲得遊戲開發商的支持。

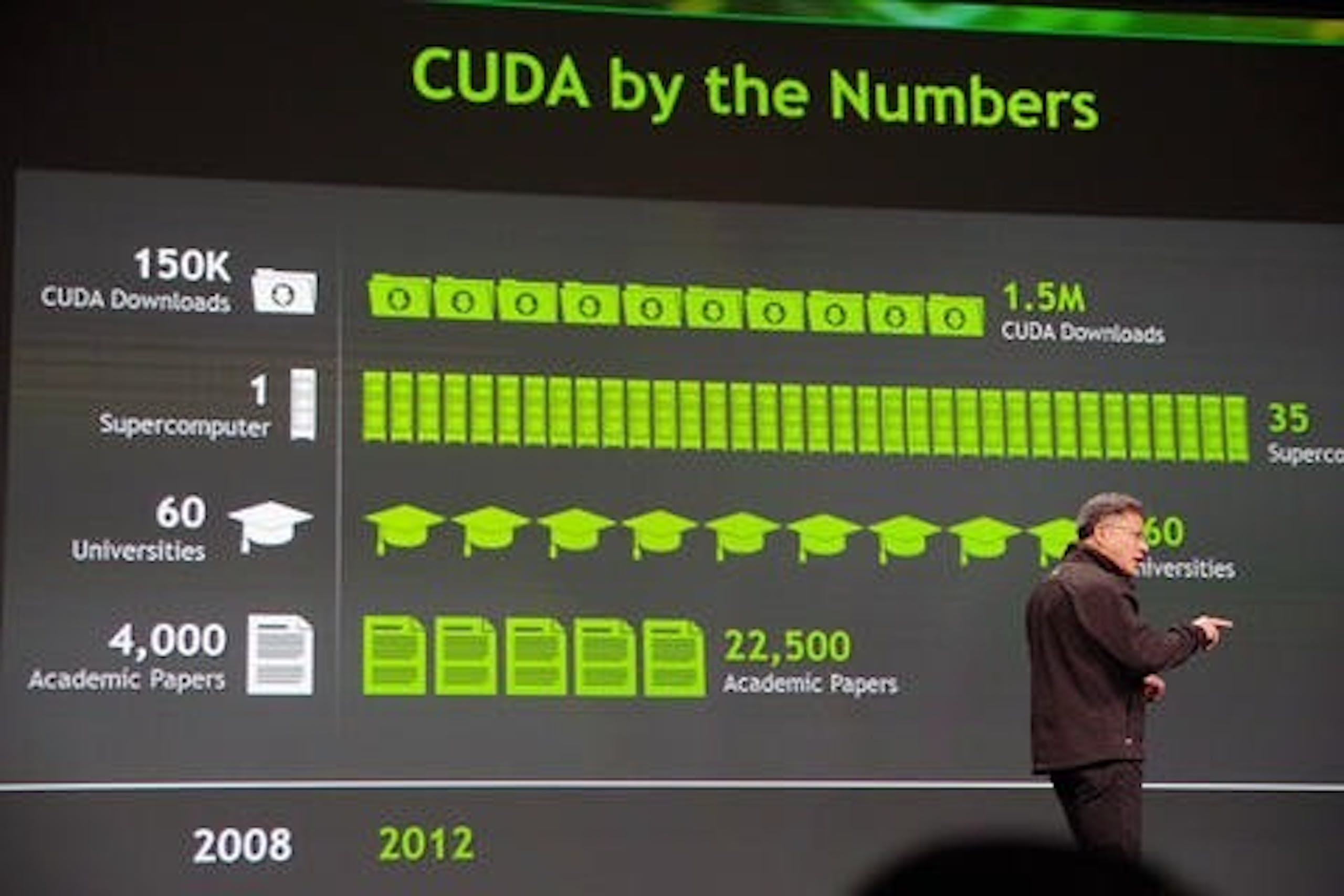

NVIDIA 發展軟體有長遠的歷史,以 CUDA 之於 GPU 加速運算為起始,而在 AI 的世代, NVIDIA 更積極攜手相關業者提供多項開發工具,以及提供大量的預訓練模型,同時也持續進行軟體更新持續提升效能與效率,在 GTC 2023 更宣布擴大與公共雲服務業者合作提供基於雲的開發環境等等,使 AI 成為不需要特殊專業亦可取用,是 NVIDIA 借助提供軟體與開發相關資源的重要目標。

▲ Grace CPU 是 NVIDIA 試圖減少不得不與同床異夢的 AMD 以及 Intel 配合的策略

若從產業發展的角度, NVIDIA 能夠在 AI 發展的歷程始終維持屹立不搖且廣泛被採納,可歸功於 NVIDIA 透過一連串完善的軟體開發環境提供猶如 CPU 一樣的通用性,不像專用加速器僅針對特定領域最佳化,也不像 FPGA 有較高的開發門檻,即便是在車載電腦平台另起爐灶的 Tesla ,仍向 NVIDIA 採購超算系統作為包括產品開發、自駕模擬等應用;對目前發展仍未有定論的 AI 產業, NVIDIA 在對於各種前仆後繼的新演算法的對應能力仍是相對有彈性,且別忘了 NVIDIA 在此領域的軟體開發因應亦相對其它競爭對手更積極。

不過在當前 AI 的發展歷程, NVIDIA 雖然在硬體供應具有領導地位,但 NVIDIA 仍不打算成為 AI 發展檯面上的領導者,而是作為一家 AI 領域的軍火商,持續供應 AI 產業利器促使產業進步與革命,如同在 GTC 2023 ,黃仁勳亦特別強調他當時親手將硬體交給 OpenAI ,當時也沒有人能預見現行由 OpenAI 推出的 ChatGPT 在一瞬間顛覆多項產業,然而在此同時, NVIDIA 也未單押與 ChatGPT 的合作,仍持續與各方合作並供應硬體。

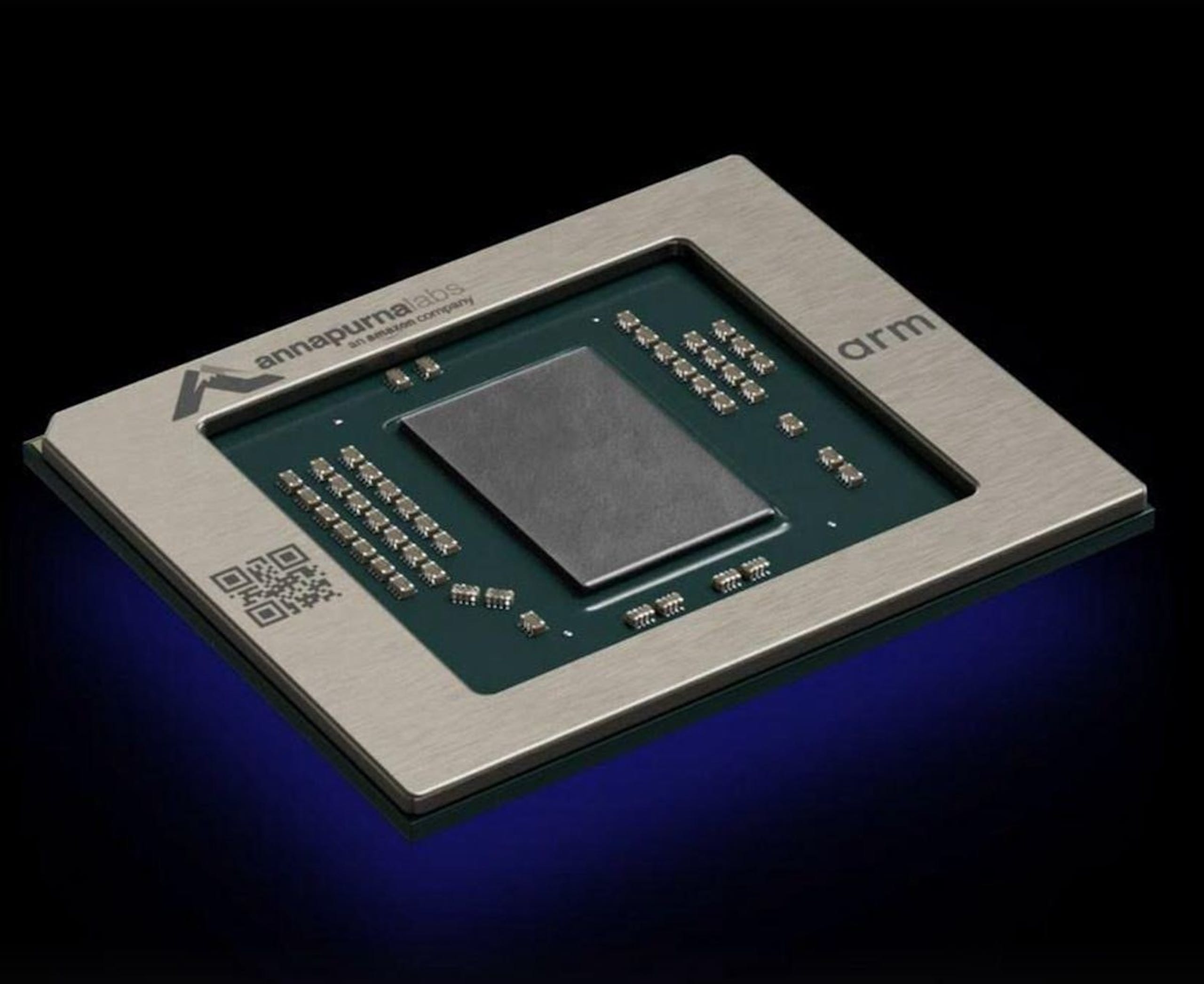

▲除了面對 AMD 與 Intel , NVIDIA 也不敢輕忽亞馬遜、 Google 的自研晶片發展

同時 NVIDIA 雖然在當前 AI 的技術發展看似握有顯著的優勢,但 NVIDIA 仍不敢輕忽整個產業可能的變化,畢竟相較握有 CPU 發展優勢的 AMD 與 Intel , NVIDIA 基於 Arm 的 Grace CPU 還需要時間證明其優勢, NVIDIA 也不敢直接中斷與 AMD 以及 Intel 的合作,但 AMD 與 Intel 也與 NVIDIA 同床異夢,希冀藉由持有的資源發展專屬的異構加速平台,同時 NVIDIA 雖與各雲端服務商保持合作,但如 Google 、亞馬遜也積極導入自研專用晶片降低對外廠的依賴,更使 NVIDIA 不敢輕忽瞬息萬變的產業動態。

▲ NVIDIA 堅守 GPU 加速運算、軟體開發與積極因應產業變化,奠定今日 NVIDIA 能夠在 AI 取得先機的基礎

若從筆者接觸 NVIDIA 與參與 GTC 大會近 10 年,筆者認為 NVIDIA 能取得當前的技術領先並非單純的幸運,而是 NVIDIA 在發展決策的堅持與靈活應變; NVIDIA 至今仍堅守以 GPU 加速為核心以及積極發展軟體平台的模式,同時在積極探查 GPU 加速於各領域應用的同時也迅速做出決策、甚至放棄既有的布局(例如原本用於手機與平板的 Tigra 說停就停),但也能將資源轉化到不同領域( Tigra 奠定當前在自駕車平台與工業自動化的基礎),前瞻而靈活的策略是成就當今 NVIDIA 從谷底翻身的關鍵。終究看著別人的成功模式如法炮製成果絕對有限,天時、地利與人和是成功的關鍵,能夠在正確的時機做出決策才能取得成功。