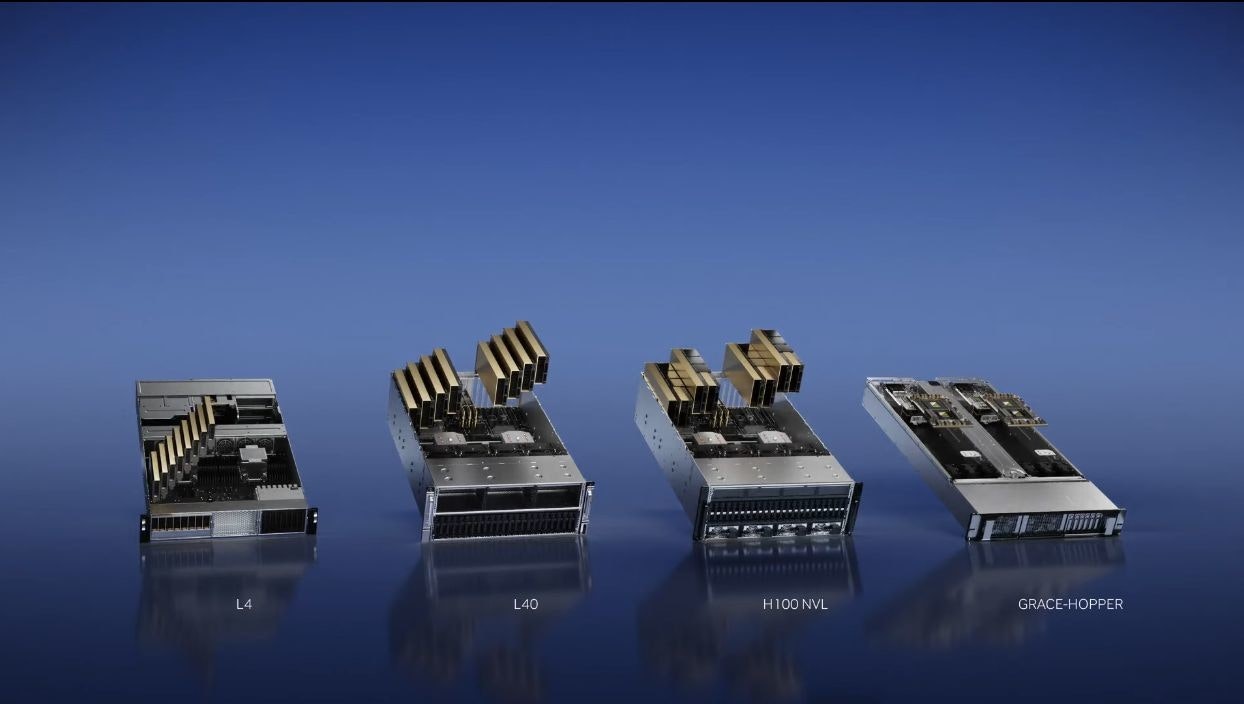

NVIDIA 宣布擴大採用新世代架構的推論產品新陣容,在 GTC 2023 公布針對基礎設施與低功耗的 NVIDIA L4 GPU ,以及針對大型語言模型佈署、採用高相容性 PCIe 介面的 NVIDIA H100 NVL 模組。在這兩項推論新品加入陣容後,與先前已經公布的 NVIDIA L40 GPU 、 Grace Hopper Superchip 構成基於新世代架構的推論產品線。 NVIDIA 希冀藉由更廣泛且彈性的加速運算系統,迎接 AI 的「 iPhone 時代」(註:指 AI 將迎來如 iPhone 帶動智慧手機一樣的時期)。

NVIDIA Grace Hopper Superchip 與 NVIDIA H100 NVL GPU 預計在 2023 年下半年推出, NVIDIA L4 與 NVIDIA L40 兩款加速產品已陸續由合作夥伴與雲服務商開始提供;其中 NVIDIA L4 GPU 可透過 Google Cloud Platform 開放非公開預覽。

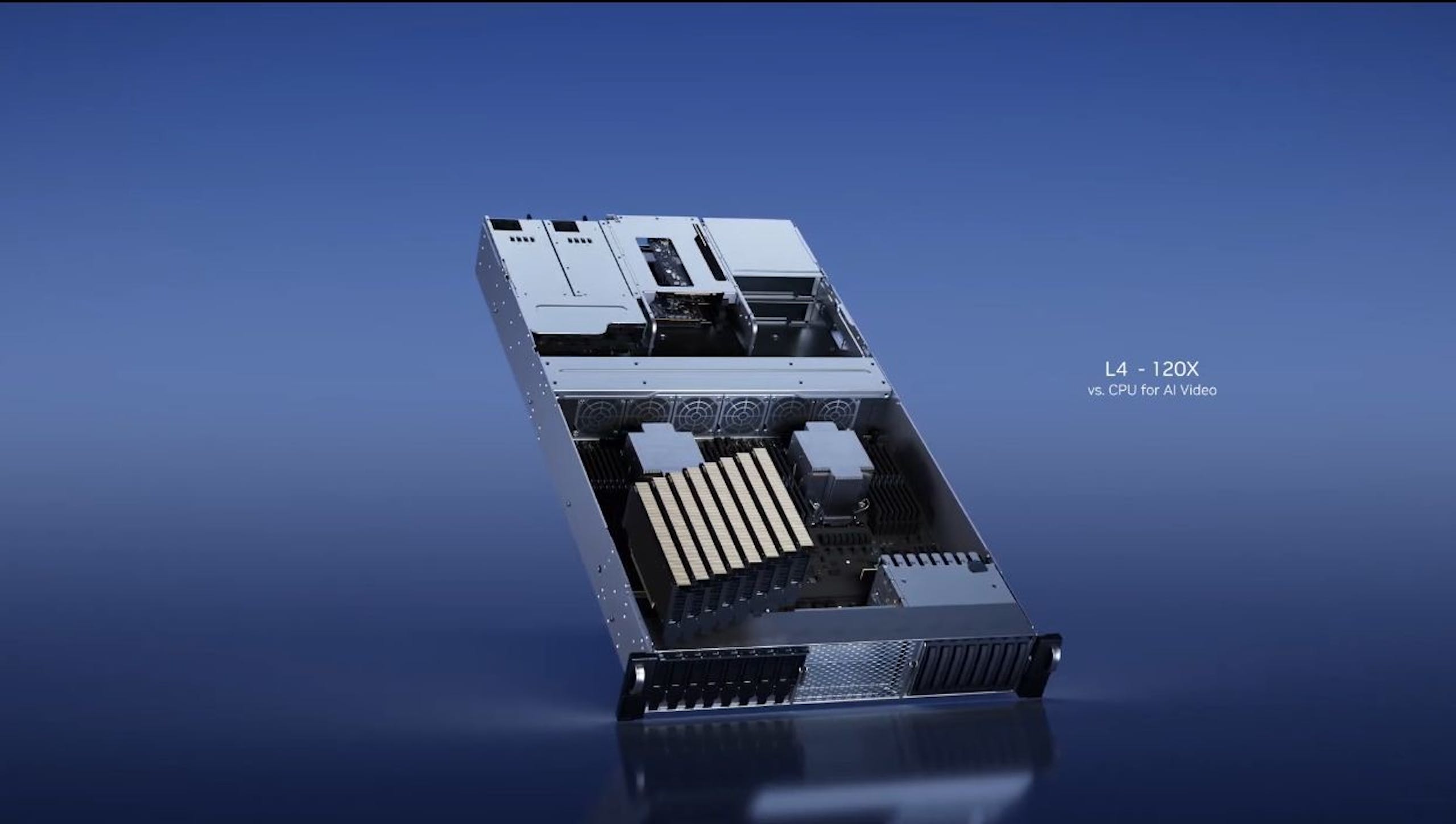

▲ NVIDIA L4 著重於影像處理,強調一台具倍 8 張 L4 的伺服器具倍等同百台雙 CPU 插槽的伺服器

NVIDIA L4 是著重節能與高效率的推論產品,適用於邊際運算基礎設施領域、尤其針對影像處理,採用易於安裝的單槽 Low-Profile 設計, NVIDIA 強調 NVIDIA L4 相較前一代同級產品提升 4 倍圖形效能與 2.7 倍 AI 效能,對比 CPU 具備 120 倍的 AI 影像效能與提升 99% 的能源效率,並具備支援任何可使用通用 GPU 的工作負載,並具備增強影像編碼、轉碼、擴增實境與生成式 AI 影像。

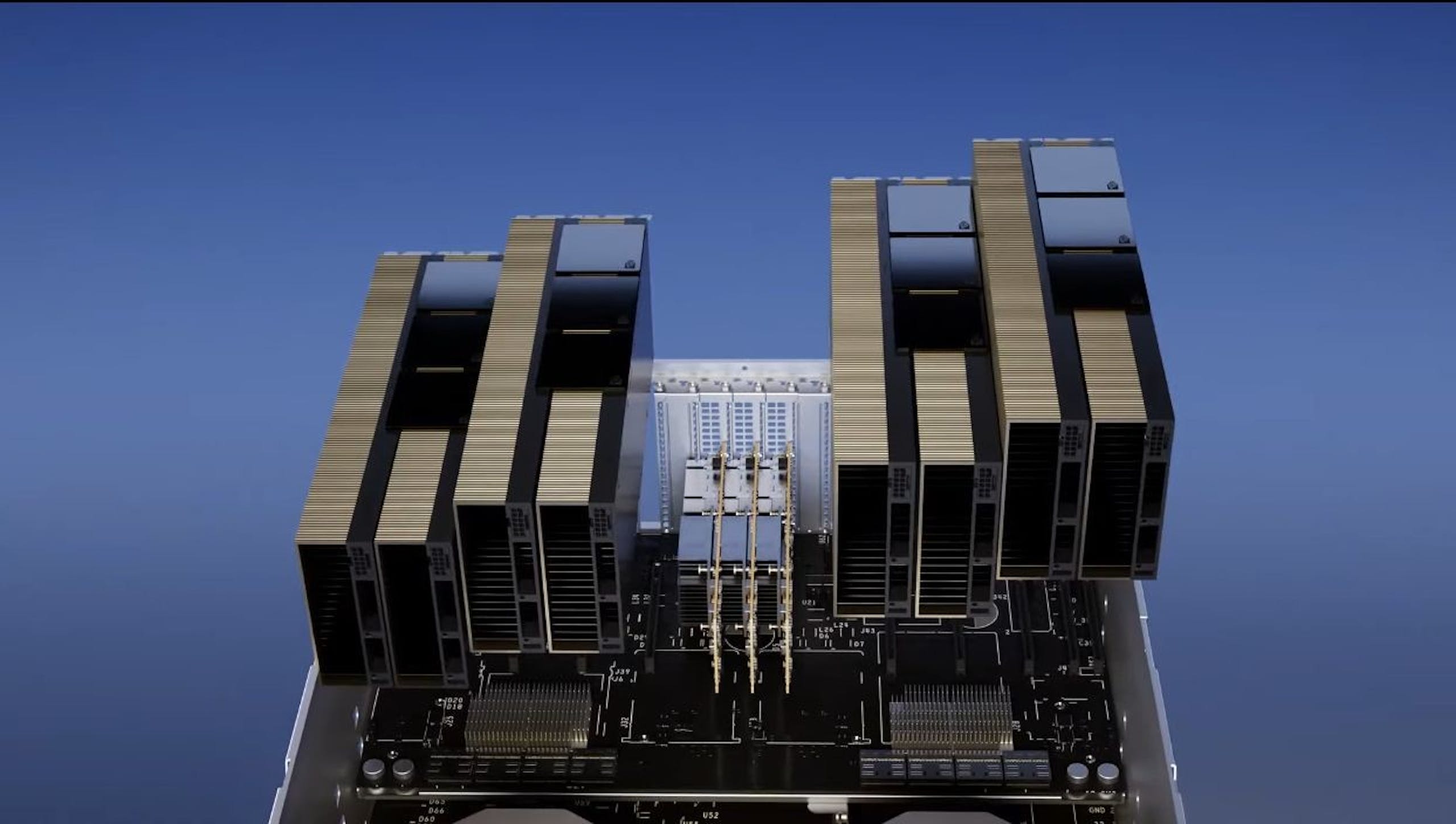

▲ NVIDIA H100 NVL 模組式將兩張 H100 以 NVLink 進行連接,但仍採用伺服器系統主流的 PCIe 介面與 CPU 溝通

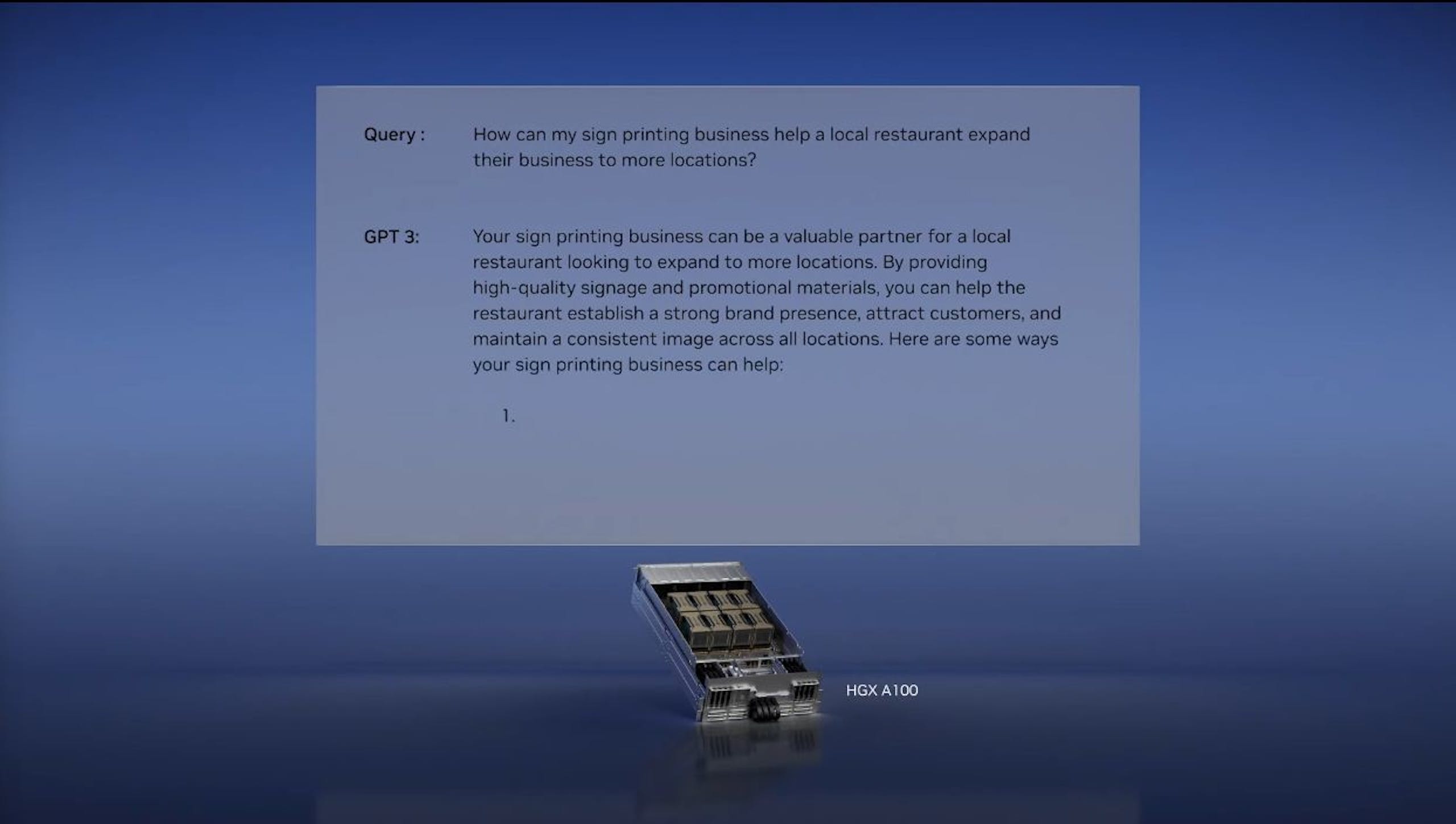

▲ H100 NVL 相較 A100 在執行 Chat-GPT 更具效能與成本效益

NVIDIA H100 NVL 則是鎖定佈署大型語言模型( LLM )的市場需求,例如大型 ChatGPT 模型,借助 NVLink 將兩張 NVIDIA H100 進行連接,再以 PCIe 與 CPU 系統連接,等同提供 94GB 的單卡記憶體,相較資料中心級的 NVIDIA A100 ,借助新架構與支援 Transformer Engine ,可在 GPT-3 推論提升 12 倍效能。

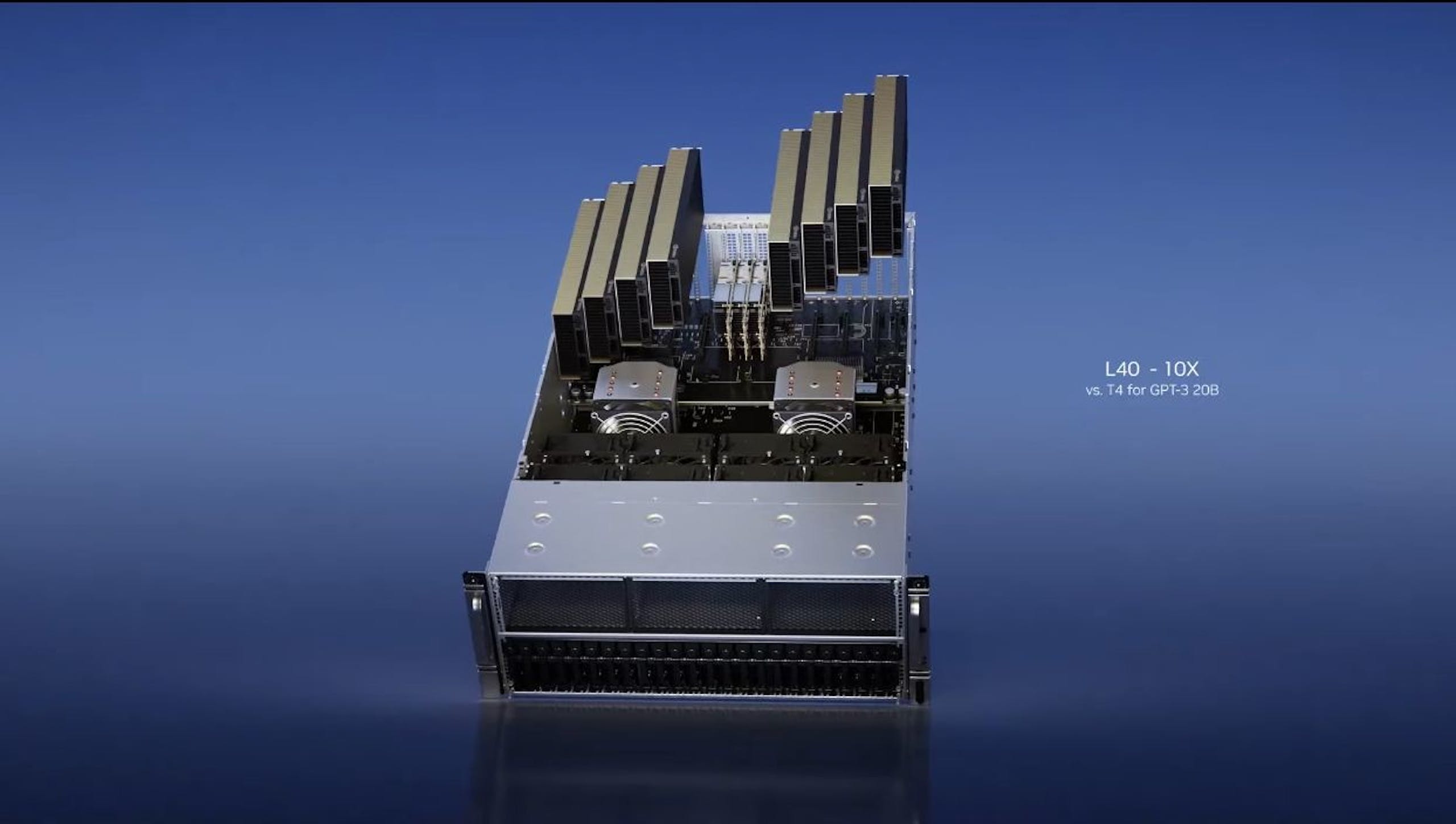

▲ L40 相當適合生成式 AI 應用

至於 NVIDIA L40 則是針對圖形與支援 AI 的 2D 、影片與 3D 等內容生成 AI 的重要產品,也是第三代 OVX 圖型運算系統的關鍵組件,作為執行 NVIDIA Omniverse 進行數位孿生,相較上一代產品提升 7 倍推論性能與 12 倍的 Omniverse 效能。

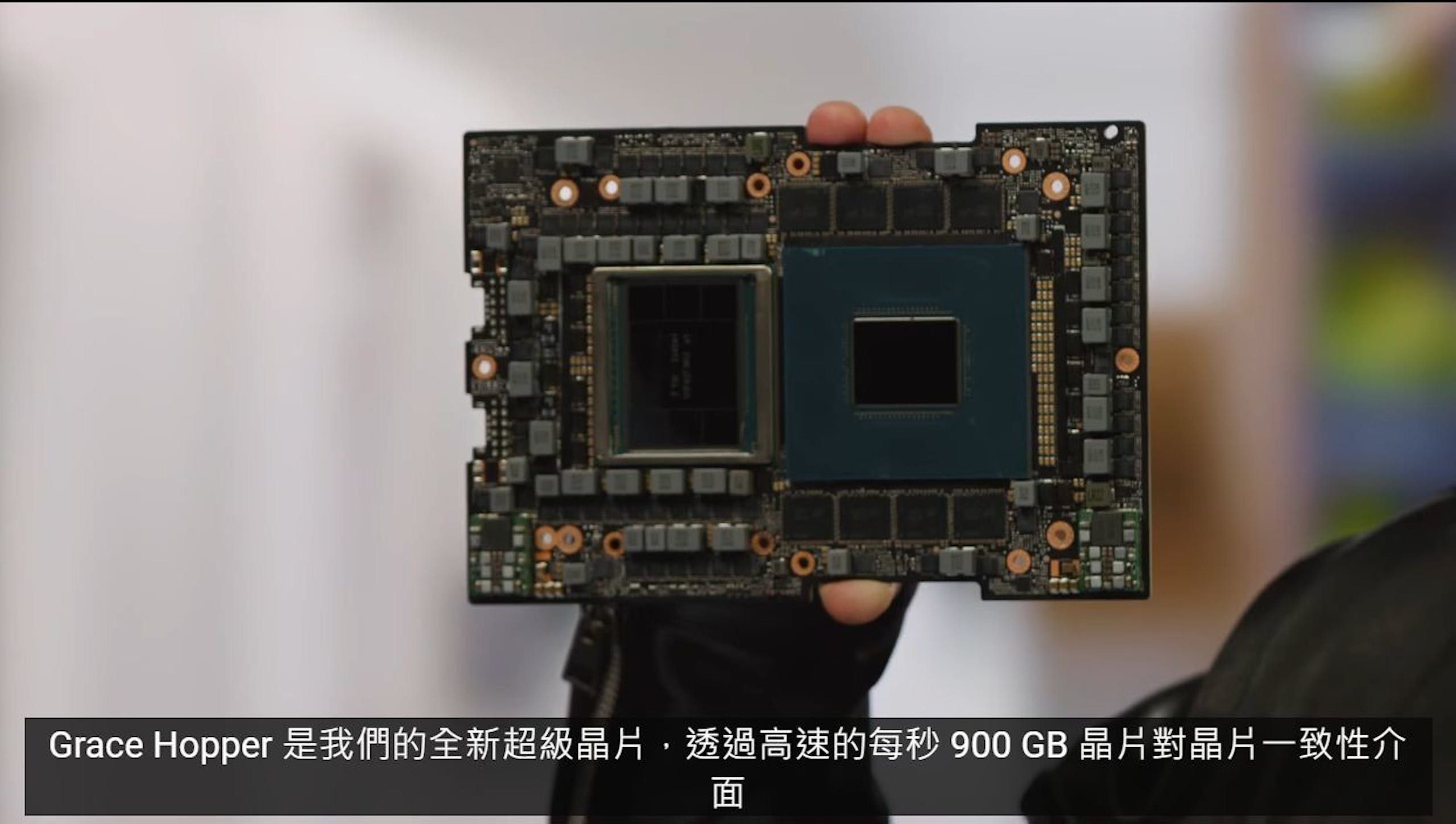

▲ Grace Hopper Superchip 能為推薦模型提供出色的效能

而基於 NVIDIA Grace Hopper Superchip 則能為推薦模型提供出色的效能,借助高達 900GB/s 頻寬的 NVLink-C2C 使 CPU 與 GPU 能高速溝通,相較使用 PCIe Gen 5 串接的 Grace CPU 與 Hopper GPU , Grace Hopper Superchip 具備 7 倍的溝通頻寬。