NVIDIA Research 公布一項名為 GET3D 的 3D 模型自動產生技術,旨在協助 3D 內容創作者可快速獲得準確的 3D 物件; GET3D 藉由 AI 技術,利用 2D 影像進行訓練即可產生具逼真的紋理與複雜幾何的 3D 物件,同時可將這些 3D 模型匯入 3D 渲染器與遊戲引擎進行後續編輯, GET3D 能產生的內容自動物、車輛、人物、建築物、戶外空間甚至到整個城市。

遙想未來,資源有限的小型遊戲工作室或是元宇宙藝術家能夠借助 GET3D 技術產生豐富的基本 3D 物件,團隊內的 3D 藝術家可集中在重新調整主要角色 3D 模型的細節,將次要物件進行簡單的編修,即可創造具有豐富 3D 物件的 3D 世界。

GET3D 的全稱是 3D Generate Explicit Texuture 3D ,表示 GET3D 可藉由三角網格建立各式形狀,如同在混泥紙漿模型覆蓋紋理材料,故藉由 GET3D 產生的物件能夠導入主流 3D 內容創作工具與遊戲引擎進行後續的編輯。

傳統用於將真實物件建立 3D 模型的逆向渲染法是透過拍攝真實物件的 2D 多視圖建構 3D 影像,但每組照片僅能產生一組 3D 模型,效率並不高;而 GET3D 是將 2D 圖像的對抗生成網路進行延伸應用,使其在產生 2D 影像的同時產生 3D 物件,最後透過 NVIDIA GPU 進行推論,每秒可產生 20 個形狀,過程猶如藝術家看著圖片捏出黏土模型後再上色一般。

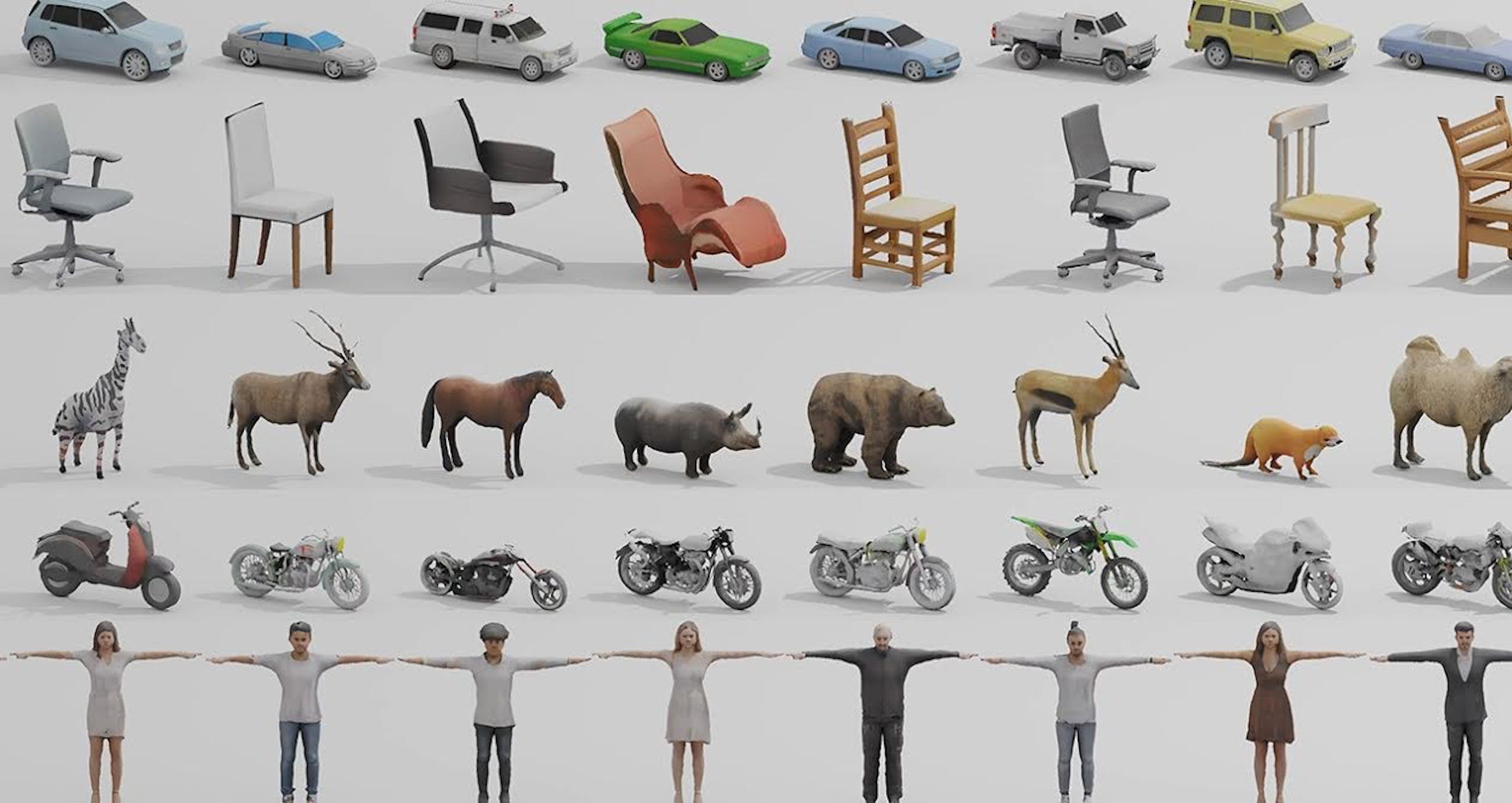

▲目前 GET3D 仍僅能一次針對一種類型的 2D 圖片進行 3D 物件訓練與產生,未來將朝可一次投入多種類型內容並進行各類的 3D 物件產生為目標

NVIDIA Research 透過不同角度拍攝的 3D 形狀的 2D 圖片進行訓練,在 NVIDIA A100 Tensor GPU 進行達 100 萬張的圖片,在兩天內完成 GET3D AI 模型。當模型完成後,投入 2D 汽車圖片資料集, GET3D 及可產生 3D 的轎車、卡車、賽車與貨車;若改為 2D 動物圖集,則可產生 3D 的狐狸、犀牛、馬與熊;換成 2D 椅子圖片,即可創作各式 3D 轉椅、餐椅與躺椅等。

這些產生的內容不僅能匯出到各式的繪圖應用程式,再搭配同樣由 NVIDIA Resarch 開發的 StyleGAN-NADA ,即可藉由文字敘述添加各式效果,如為 3D 房子物件加入頹圮效果,或是將完整的 3D 汽車變成經過擦撞甚至燒毀的效果。

研究團隊指稱 GET3D 後續版本還可結合攝影機姿勢預估技術可使用真實環境而非合成資料進行模型訓練,同時也將持續進行 GET3D 模型使其支援通用生成技術,屆時能夠一次使用各種 3D 形狀進行訓練,而非現行僅能一次使用一個種類的物件進行訓練。

1 則回應

中教樂多 166.45.D.22歲 試車5000