受武漢肺炎影響, NVIDIA 將今年初幾場取消的活動內容集中在稍早 GTC 線上主題演講發表,而備受矚目的新一代 GPU 架構 Ampere 也藉此次活動正式發表,第一款採用 Ampere 架構的 GPU 產品 NVIDIA A100 GPU 也全面投產,相較前一代 V100 GPU 在 AI 訓練提升達 20 倍效能,搭載 8 顆 NVIDIA A100 之 HGX A100 模組可具備 10 Petaflops 效能。

NVIDIA A100 GPU 在產品定位是作為通用型運算之 Volta 架構的 V100 GPU 的後繼產品,是專為 AI 、通用運算、數據分析、科學計算與雲端影像等應用所設計,同時藉由整合運算與 AI 訓練、推論等,使單一平台能夠進行數據分析與 AI 相關應用,以強大且綜合運算與 AI 訓練與推論的特性,降低資料中心的整體成本。

▲ NVIDIA A100 是目前地表最龐大且最複雜的 7nm 晶片

▲第三代 Tensor Core 具備 TF32 ,使其在 AI 性能較 V100 提升 20 倍

作為 Ampere 架構首發的 NVIDIA A100 採用台積電 7nm 製程,具備高達 540 億個電晶體,是目前地表最大的 7nm 處理器;為了因應 AI 需求, NVIDIA A100 晶片具備 TF32 的第三代 Tensor Core ,藉由 TF32 可使 FP32 精度的 AI 運算提高 20 倍,同時 Ampere 的第三代 Tensor Core 還可支援 FP64 ,有助於 HPC 運算,相較 Tesla V100 可提高 2.5 倍 HPC 運算量。

▲結構化稀疏進一步藉由掌握 AI 數學稀疏特性強化算力

同時, NVIDIA A100 導入全新的結構化稀疏 ( Structural Sparsity )技術,透過掌握 AI 數學原本稀疏之特性,強化 AI 運算之性能。

▲ MIG 技術使每個 A100 GPU 可作為 7 個執行個體

NVIDIA A100 採用創新的 MIG ( Multi Instance GPU ;多重執行個體 GPU )彈性運算技術,可針對不同規模的運算提供合宜的效能分配,單一的 NVIDIA A100 能夠切分為七個獨立的 instances (執行個體),使其進行獨立多工,相較 V100 提升 7 倍的 Throughput 。就架構特性,似乎可視為單一的 NVIDIA A100 GPU 實質上等同 7 顆獨立 GPU 構成,此 7 顆 GPU 能進行協作或是獨立運作。

▲ NVIDIA A100 延續 NVIDIA 超算晶片之 NVLink 連接技術與 HBM 記憶體

同時 NVIDIA A100 也具備第三代的 NVLink 互聯技術,使多個 A100 GPU 藉由高速、低延遲的通道彼此連接並共享記憶體,使多個 GPU 能溝通無阻、宛若單一超大型 GPU ,能做為執行巨型 AI 模型訓練與進行高附載運算、模擬等應用。

為了發揮 NVIDIA A100 的最大效能, NVIDIA 也宣布全新的軟體堆疊,包括多達 50 種 CUDA-X 庫,提供圖形加速、圖像仿真、 AI 、 CUDA 11 ,針對多模式對話 AI 的 Jarvis ,深度推薦程式應用程式框架的 Merlin ,針對 HPC 的 NVIDIA HPC SDK 等,協助開發者第一時間能發揮 NVIDIA A100 的最大效能。

▲ NVIDIA DGX A100 是第三世代 DGX ,可提供達 10 petaflops 的 Int 8 與 5 Petaflops 之 Int 16 算力

NVIDIA 也在今日宣布推出全新的雲計算系統 NVIDIA DGX A100 ,這也是 NVIDIA 第三世代的 DGX 系統,搭載 8 個採用 NVLink 技術相互連接的 NVIDIA A100 GPU ,將透過 NVIDIA 與認證合作夥伴開始供貨。

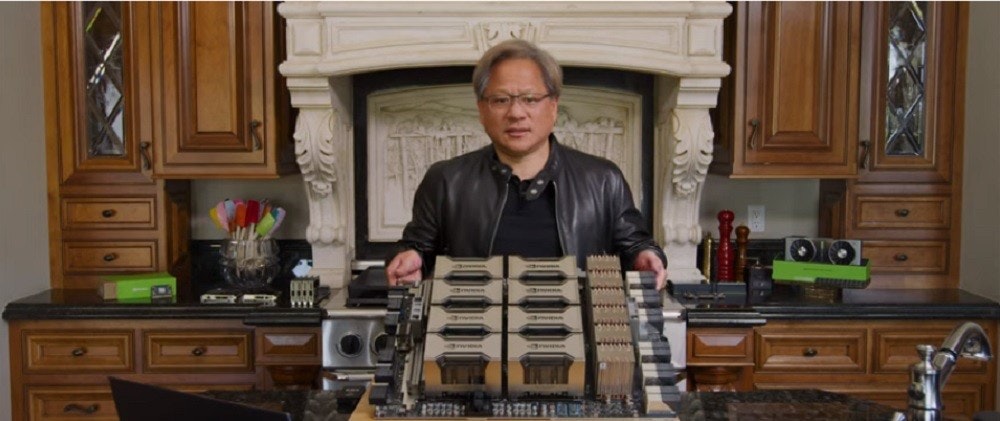

▲單一載板 8 GPU 之 HGX A100 設計使伺服器廠商可加速產品布局

NVIDIA 也為了使系統業者能更容易開發基於 NVIDIA A100 的伺服器, NVIDIA 提供了 HGX A100 的多 GPU 整合平台,也就是執行長黃仁勳在早先預告片中自烤爐拿出的模組,在單一 HGX A100 可透過 NVLink 實現 4 顆 NVIDIA A100 GPU 的相互連接,若要擴展到 8 顆 NVIDIA A100 ,則須搭配 NVIDIA NVSwitch 提供全頻寬的相互連接。

透過 NVIDIA A100 的 MIG 技術,一套具備 8 顆 NVIDIA A100 的 HGX A100 平台,既可視為 56 個小型 GPU ,且單一顆 GPU 皆具備超越前一代 Tesla T4 更高的性能,或是將 8 顆 Tesla A100 效能合併,達到 10 Petaflops 的性能。

目前亦有多家系統業者、雲服務商宣布將導入 NVIDIA A100 GPU ,包括阿里雲、亞馬遜 AWS 、 Atos 、百度雲、 Cisco 、 Dell 、富士通、技嘉、 Google Cloud 、 H3C 、 HPE 、 Inspur 、聯想、微軟 Azure 、甲骨文、廣達/雲達、美超微與騰訊雲等。

▲多家服務商與系統業者已經著手規劃基於 HGX A100 的伺服器系統

微軟也宣布在第一時間於 Azure 提供 NVIDIA A100 的服務,藉由更高的運算力,使其能作為新一代自然語意模型訓練、機器視覺等多元的 AI 訓練。

同時,亦有多套新世代超級電腦系統宣布導入 NVIDIA A100 ,包括採 HPE Cray Shasta 的美國印第安納大學的 Big Red 200 ,由 Atos 架構的德國 Julich 超算中心,德國 Karlsruhe 技術學院與聯想打造的 HoreKa 超級電腦,同樣由聯想為德國 Max Planck 設計的 Raven ,美國能源局勞倫斯柏克利國家實驗室籌畫、採 HPE Cray Shasta 的 Perlmutter 。