自 NVIDIA 於 20 年前的 1999 年開始使用 GeForce 這個子品牌,並在 2005 年的 GeForce 7800 GTX 首度開始使用 GTX 的代稱,而在 2018 年的德國科隆遊戲展活動, NVIDIA 也正式公布使用 Turing /圖靈 GPU 架構的 GeForce RTX 20 系列 GPU ,從 GTX 邁入 RTX ,此次的 GeForce RTX 20 不僅只是單純的性能提升,也象徵迎接即時光線追蹤的革命變革。

Turing /圖靈晶片第一彈 TU102 與 TU104

看一顆晶片前,除了性能以外,多半消費者也會想知道基礎架構的設計,做為 GeForce RTX 2080 Ti 與 Quadro RTX 6000 / RTX 80000 的 Turing / 圖靈架構的晶片,其 TU102 採用 72 個 Turing SM ,包括 4,352 個 CUDA Core , 34 個 Geometry 單元, 272 個 Texture 單元, 88 個 ROP 單元,以及 544 個 Tensor Core ,同時還有 68 個 RT Core 。

至於 GeForce RTX 2080 使用的則是與 Quadro RTX 5000 相同的 TU104 晶片, GeForce RTX 2080 具備 64 個 Turing SM ,包括 2,944 個 CUDA Core ,23 個 Geometry 單元, 184 個 Texture 單元, 64 個 ROP 單元,以及 368 個 Tensor Core ,同時還有 46 個 RT Core 。

較前一世代 Volta , Turing 圖靈使每個 Turing SM 內所包含的 CUDA Core 增加,但減少 Turing SM 的總量,同時 RTX 20 世代的 TDP 也較前一世代 GTX 10 同級產品略微提升;此外僅有 RTX 2080 Ti 與 RTX 2080 的 TU102 與 TU104 具備 NVLink 技術,預計稍後登場的 RTX 2070 並不支援 NVLink 。

雖然在 Turing 之前, NVIDIA 還有稱為 Volta 的架構,不過在產品定位上, NVIDIA 並不將 Volta 視為繪圖卡或是顯示卡的架構,而是針對科學運算、大數據、人工智慧等的運算級架構,加入 Tensor Core ,但也因為鎖定 AI 應用的 Volta 的誕生, Turing 在架構設計上也加入 Tensor Core 的設計,並帶來基於人工智慧的新功能。

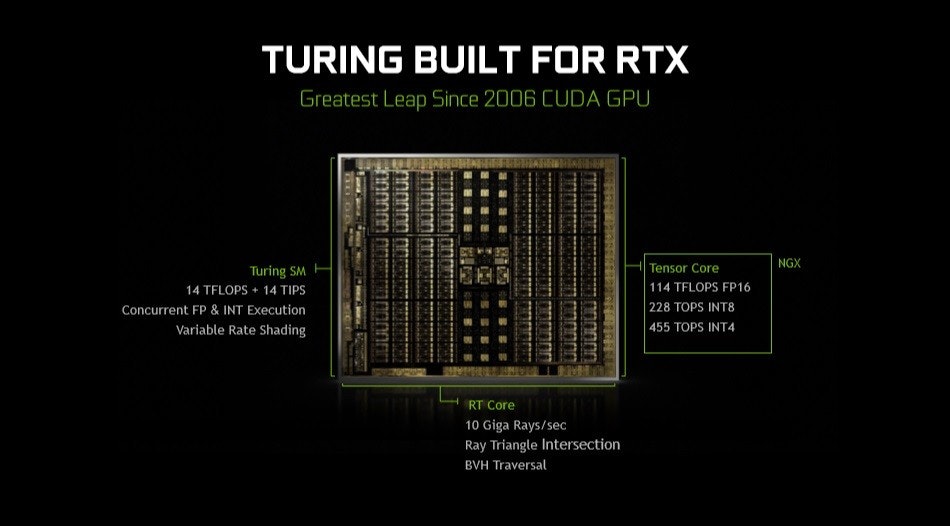

不過除了 Tensor Core 人工智慧架構外, GeForce RTX 20 能夠首度在遊戲支援複雜的即時光線追蹤效果的關鍵,就是於架構中融合全新的 RT Core ,藉由將光線在場景中與物體相互反射後的效果運算交給專屬的 RT Core ,實現更現階段遷就整體效能而使用效果較差的 Pre-Shader 的光線或是僅能運算部分光線追蹤的情況。

由 CUDA Core 搭配 Tensor Core 與 RT Core ,是 Turing 與 GeForce RTX 20 系列的核心價值,同時也宣示 GPU 與遊戲娛樂邁向人工智慧以及即時光線追蹤的新世代,也為遊戲再提升順暢性的同時,也獲得更逼真的影像效果。

RTX 2080 Turing 晶片架構、記憶體設計解密

此次 Turing 架構的基礎是建立在全新的 TURING SM 上,全新的 TURING SM 具備四組管線與一組 RT Core ,一組管線內整合包括 INT 32 、 FP32 以及 Tensor Core ,同時在記憶體存取架構也採用全新的設計,使 Turing 獲得更大的頻寬,並且每個核在 SHADING 的性能較 Pascal 架構高出 50% 。

不同於 Pascle 架構使用單一個存取單元搭配 L1 與 L2 快取,並具備共享記憶體設計,此次 Turing 不僅加倍 L1 與 L2 的快取容量,相較 Pascal 提升 2.7 倍的 L1 與 2 倍的 L2 容量,同時採用將 L1 快取與共享記憶體整合的設計,可彈性的依照需求將 L1 與共享記憶體分配成 64KB + 32KB 或是 32KB + 64KB ,並且 L1 的延遲更短、也提升 2 倍的 L1 頻寬。

此外, Turing 架構搭配的是新一代的 GDDR6 記憶體,也是業界首家採用 GDDR6 記憶體的產品;雖非 Volta 的 HBM2 記憶體,但以消費級距的需求, GDDR6 相較 Pascal 使用的 GDDR5 仍有長足的提升,能夠帶來 14Bbps 的記憶體高速介面,同時降低 40% 的 Crosstalk ,而在結果論,就是提升 50% 的頻寬效率。

同時 Turing 核心也加入與 Volta 相同的 Tensor Core 人工智慧加速核心,能針對人工智慧推論進行加速,同時也將人工智慧應用在全新的影像強化上,而基於 Turing 圖靈架構的 TU102 完整核心的 Tensor Core 可達到 114TFLOPS FP16 、 228 TOPS INT8 與 455 TOPS INT4 的性能。

RT Core 為實現單卡即時光線追蹤帶來曙光

雖然即時光線追蹤並非新技術,不過由於光線追蹤牽涉到複雜的物理運算,過往需要耗費龐大的運算資源,也就難以遊戲娛樂為主的個人電腦上實現,今年初雖然利用一台搭載 Tesla V100 的 DGX-2 的超級電腦展示即時的光線追蹤效果,不過達 8 萬美金亦只有專業開發者才可能負擔,然藉由 Tensor Core 與全新的 RT Core ,以單卡就能達到複雜的即時光線追蹤。

在過往,若要實現光線追蹤只能透過 GPU Compute 的方式演算並進行 Render ,但這也導致 GPU 一方面要負擔原本的影像內容處理,又要運算光線的物理效果以及進行光線的 Render ,即便是專業影像工作站亦難有良好的表現,如同電影過往的光影後製處理,也需要透過由大量工作站同步處理的 Render Farm ,更不用說遊戲用的個人電腦要達到即時光線追蹤。

而在深度學習的演算法、框架以及 GPU 運算逐漸成熟後,藉由利用深度學習的預測功能,能夠推測出在即時光線追蹤當中對於視覺沒有影響的反射、折射結果,在運算時撇除這些不必要的光線路徑,降低對運算的負擔,而在先前的 Volta 架構,更能利用專為深度學習的 Tensor Core 更有效率的執行這些框架,但仍需要複雜的運算與 GPU 資源。

不過在 Turing 架構當中,除了利用 Tensor Core 降低運算負擔以外,更重要的是藉由針對光線追蹤的專屬硬體加速架構 RT Core ,每組 RT Core 包含三角形與矩陣光運算構成,將光線追蹤相關的演算透過 RT Core 執行,而 Shader 可專心的執行 Shading ,將整個即時光線追蹤的過程分工,也終於實現單卡的 Ray tracing 。

以同樣隸屬旗艦卡的等級, Pascal 架構的 GTX 1080 Ti 約具備 1.1 Giga Rays 的光線追蹤能力,然而 RTX 2080 Ti 藉由具備 RT Core ,能提供超過 10 Giga Rays 的光線追蹤性能,較 GTX 1080 Ti 提升 10 倍的光線追蹤表現。

同時 NVIDIA 也針對新世代的即時光線追蹤提出全新的性能計算單位,稱為 RTX-OPS ,而當前的 RTX 2080 Ti 可達到 78 RTX-OPS 的性能;至於 78 這個數字怎麼產生? NVIDIA 也提出其計算公式,是以 80% 的 FP32 運算性能,加上 28% 的 INT32 性能,以及 40% 的 RTOPS 性能,最後加上 20% 的 TENSOR 性能構成。

新世代的影像規範支援

在 Pascal 到 Turing 的這兩年間,市場的影像需求也有相當大的變化,故 Turing 從編碼與輸出介面亦針對新趨勢進行革新,在基本影像編解碼部分,編碼可支援到即時的 8K 30P HEVC ,同時解碼亦支援 VP9 10/10bit HDR , HEVC 4:4:4 10/12bit HDR 等新規格,可因應接下來從 4K 到 8K , SDR 到 HDR 的影像產業變革。

此外, Turing 圖靈架構的 GPU 可搭配新一代基於 USB Type-C 介面的影像輸出,同時也不光是支援 DisplayPort over USB Type-C 的協定,更重要的是還支援針對 VR 的 VirturalLink ,此協定可透過單一 VirturalLink 線材連接到支援的 VR 頭戴顯示器,並一舉提供影像、 USB 還有供電,且針對 VR 應用盡可能降低延遲、提升同步。

以發揮 Tensor Core 應用的 NVIDIA NGX

雖然對玩家而言,作為人工智慧應用的 Tensor Core 似乎與遊戲、娛樂的關聯不夠直接,除了用於實現即時光線追蹤作為光線預測的一環之外也不清楚 Tensor Core 還能對一般消費者發揮甚麼作用;而 NVIDIA 為了使 Tensor Core 能夠為玩家帶來更多附加價值,推出名為 NVIDIA NGX / Neural Graphics Framework (神經圖形框架)。

NVIDIA NGX 顧名思義就是透過基於機械神經網路的 AI 技術用於圖像相關的應用,而這些 AI 應用的模型當然不會由玩家自行訓練, NVIDIA 將會透過其超級電腦進行相關模型的產生,消費者與內容開發者未來僅需要搭配這些模型,就能為圖像、影像帶來基於 Tensor Core 的 AI 強化。

當前 NVIDIA NGX 的應用有許多都是先前 NVIDIA 研究單位所提出的應用,例如 AI Super Rez / AI 超解析模式, AI Slow-Mo / AI 超級慢動作 , AI Inpainting 等,這些都是透過深度學習的方式,使 AI 能將低解析度的影片可透過 AI 演算產生媲美原生高解析度的影片、照片,或是將 30fps 的影片變成流暢、不停格的 240fps 影片,幫舊照片上色等。

全新的遊戲細節提升體驗: NVIDIA DLSS

先前提到的 NVIDIA NGX 應用,多半是針對影音娛樂的部分,針對遊戲, NVIDIA 也透過名為 NVIDIA DLSS 的影像提升技術,作為提升遊戲畫質的新方式;當前用於提升遊戲畫質的方式,通常是利用反鋸齒相關的技術,只要開啟反鋸齒,就會影響到運算效能,而且為了畫面的精緻而開啟高倍反鋸齒,基本上不太可能有良好的遊戲體驗。

NVIDIA DLSS 是一種顛覆性的影像強化技術,這是利用 NVIDIA 的超級電腦將進行高倍取樣(如 64 倍的反鋸齒)的遊戲畫面,透過深度學習的方式產生畫質提升用的模型,可說是類似 AI Super Res 的遊戲領域應用,由於學習的範本是來自超高精細度的遊戲影像,故當玩家在支援 NVIDIA DLSS 的遊戲開啟功能,就能以近乎不影響 GPU 效能的達到超高品質的遊戲細節。

不過由於 NVIDIA DLSS 與過往反鋸齒技術的原理不同,開發商若想要支援 NVIDIA DLSS 的方式並非透過 API ,而是加入 NVIDIA NGX 的開發計畫,屆時將由 NVIDIA 針對開發商的遊戲進行超取樣後,再透過超級電腦進行 NVIDIA DLSS 的模型培訓,屆時玩家開啟後會從伺服器下載對應的 NVIDIA DLSS 模型並套用。不過 NVIDIA 強調此計畫不須額外的授權,僅需加入開發者計畫即可。

5 則回應